基础概念

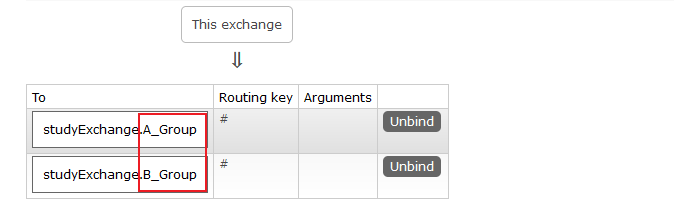

01、微服务架构

微服务架构师一种架构模式,它提倡将单一应用程序划分成一组小的服务,服务之间互相协调、互相配合,为用户提供最终价值。每个服务运行在其独立的进程中,服务与服务间采用轻量级的通信机制互相协作(通常是基于HTTP协议的Restful API)。 每个服务都围绕着具体业务进行构建,并且能够被独立的部署到生产环境、类生产环境等。另外,应当尽量避免统一的、集中式的服务管理机制,对具体一个服务而言,应根据业务上下文,选择合适的语言、工具对其进行构建。

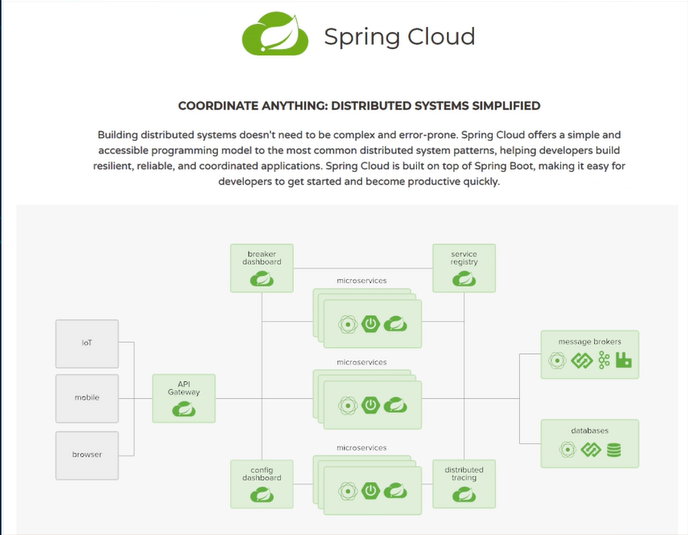

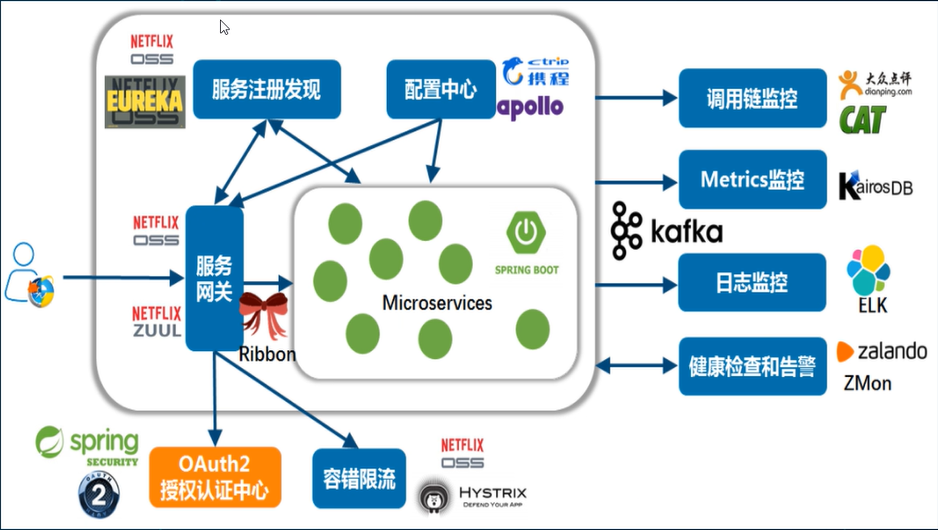

02、SpringCloud

SpringCloud=分布式微服务架构的一站式解决方案,是多种微服务架构落地技术的集合体,速成微服务全家桶

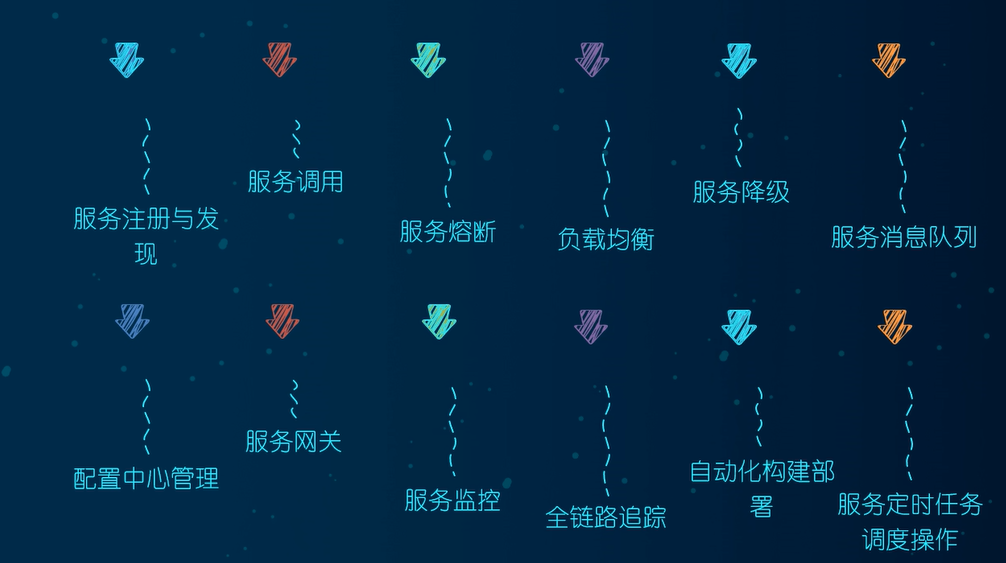

03、SpringCloud 技术栈

具体实现用到的技术

04、boot和cloud的版本选型

Spring Cloud采用了英国伦敦地铁站的名称来命名,并由地铁站名称字母A-Z依次类推的形式来发布迭代版本

SpringCloud是一个由许多子项目组成的综合项目,各子项目有不同的发布节奏。为了管理SpringCloud与各子项目的版本依赖关系,发布了一个清单,其中包括了某个SpringCloud版本对应的子项目版本。为了避免SpringCloud版本号与子项目版本号混淆,SpringCloud版本采用了名称而非版本号的命名,这些版本的名字采用了伦敦地铁站的名字,根据字母表的顺序来对应版本时间顺序。例如Angel是第一个版本, Brixton是第二个版本。当SpringCloud的发布内容积累到临界点或者一个重大BUG被解决后,会发布一个“service releases”版本,简称SRX版本,比如Greenwich.SR2就是SpringCloud发布的Greenwich版本的第2个SRX版本。

cloud Hoxton.SR1

boot 2.2.2.RELEASE

cloud alibaba 2.1.0.RELEASE

java java8

Maven 3.5及以上

Mysql 5.7及以上

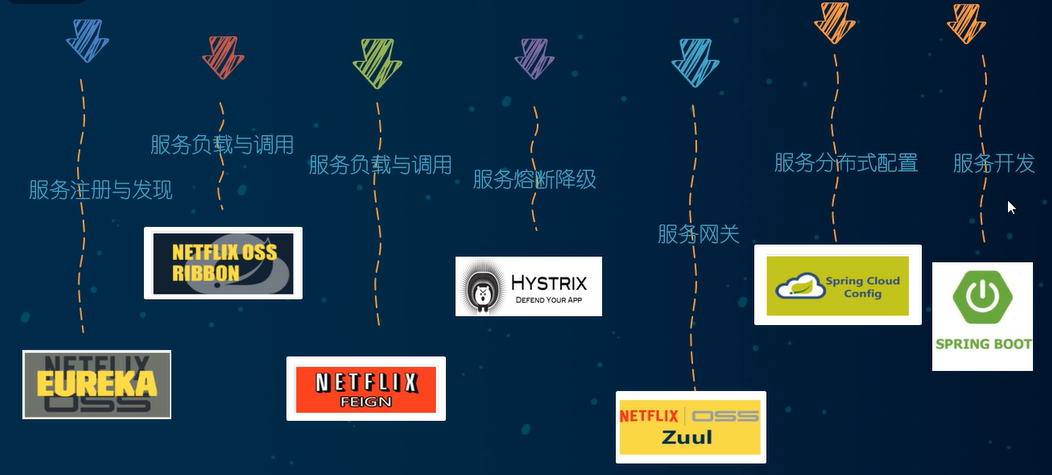

05、cloud 组件停更说明

停更不停用

- 被动修复bugs

- 不再接受合并请求

- 不再发布新版本

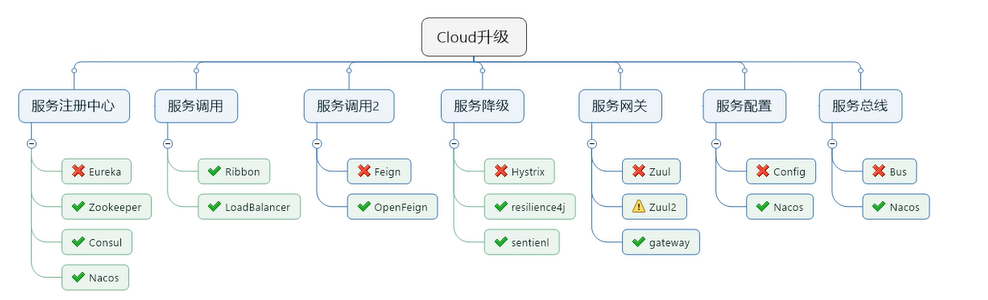

cloud升级

服务注册中心

- Eureka停用

- 可以使用zookeeper作为服务注册中心

- consul

- Nacos

服务调用

- Ribbon准备停更,

- 代替为LoadBalance

服务调用2

- Feign改为OpenFeign

服务降级

Hystrix停更,改为resilence4j

或者阿里巴巴的Sentienl

服务网关

- Zuul改为gateway

服务配置

- Config改为 Nacos

服务总线

- Bus改为Nacos

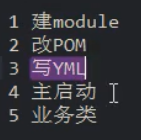

环境搭建

- New Project

- 聚合总父工程名字

- Maven选版本

- 工程名字

- 字符编码

- 注解生效激活

- java 编码版本选8

- File Type 过滤

01、新建maven父工程

在pom文件里添加

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<junit.version>4.12</junit.version>

<log4j.version>1.2.17</log4j.version>

<lombok.version>1.16.18</lombok.version>

<mysql.version>5.1.47</mysql.version>

<druid.version>1.1.16</druid.version>

<mybatis.spring.boot.version>1.3.0</mybatis.spring.boot.version>

</properties>

<!-- 1、只是声明依赖,并不实际引入,子项目按需声明使用的依赖 -->

<!-- 2、子项目可以继承父项目的 version 和 scope -->

<!-- 3、子项目若指定了 version 和 scope,以子项目为准 -->

<dependencyManagement>

<dependencies>

<!--spring boot 2.2.2-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-dependencies</artifactId>

<version>2.2.2.RELEASE</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--spring cloud Hoxton.SR1-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-dependencies</artifactId>

<version>Hoxton.SR1</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--spring cloud alibaba 2.1.0.RELEASE-->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-alibaba-dependencies</artifactId>

<version>2.1.0.RELEASE</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>${mysql.version}</version>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>druid</artifactId>

<version>${druid.version}</version>

</dependency>

<dependency>

<groupId>org.mybatis.spring.boot</groupId>

<artifactId>mybatis-spring-boot-starter</artifactId>

<version>${mybatis.spring.boot.version}</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>${junit.version}</version>

</dependency>

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>${log4j.version}</version>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<version>${lombok.version}</version>

<optional>true</optional>

</dependency>

</dependencies>

</dependencyManagement>

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

</build>dependencyManagement

Maven 使用dependencyManagement元素来提供了一种管理依赖版本号的方式。

通常会在一个组织或者项目的最顶层的父pom中看到。

使用pom.xml 中的dependencyManagement元素能让所有在子项目中引用一个依赖而不用显式的列出版本号。

Maven 会沿着父子层次向上走,直到找到一个拥有dependencyManagement元素的项目,然后它就会使用这个dependencyManagement元素中指定的版本号。

这样做的好处就是:如果有多个子项目都引用同一样依赖,则可以避免在每个使用的子项目里都声明一个版本号,这样当想升级或切换到另一个版本时,只需要在

顶层父容器里更新,而不需要一个一个子项目的修改﹔另外如果某个子项目需要另外的一个版本,只需要声明version就可。

dependencyManagement里只是声明依赖,并不实现引入,因此子项目需要显示的声明需要用的依赖。02、创建子模块

1、子模块名字

cloud_provider_payment8001

2、pom依赖

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.mybatis.spring.boot</groupId>

<artifactId>mybatis-spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>druid-spring-boot-starter</artifactId>

<version>1.1.10</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-jdbc</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

</dependencies>3、创建application.yml

server:

port: 8001

spring:

application:

name: cloud-payment-service

datasource:

type: com.alibaba.druid.pool.DruidDataSource #当前数据源操作类型

driver-class-name: com.mysql.jdbc.Driver #mysql驱动

url: jdbc:mysql://localhost:3306/db2022?useUnicode=true&characterEncoding=utf-8&useSSL=false&serverTimezone=GMT%2B8

username: root

password: mysql729

mybatis:

mapper-locations: classpath:mapper/*.xml

type-aliases-package: com.example.springcloud.pojo # 所有的entity(pojo)别名类所在包4、主启动类

@SpringBootApplication

public class PaymentMain8001 {

public static void main(String[] args) {

SpringApplication.run(PaymentMain8001.class, args);

}

}5、业务类

1、sql

CREATE TABLE `payment`

(

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT '主键',

`serial` varchar(200) CHARACTER SET utf8 COLLATE utf8_general_ci DEFAULT NULL COMMENT '支付流水号',

PRIMARY KEY (`id`) USING BTREE

) ENGINE = InnoDB CHARACTER SET = utf8 COLLATE = utf8_general_ci COMMENT = '支付表' ROW_FORMAT = Dynamic;

INSERT INTO `payment`

VALUES (31, '尚硅谷111');

INSERT INTO `payment`

VALUES (32, 'atguigu002');

INSERT INTO `payment`

VALUES (34, 'atguigu002');

INSERT INTO `payment`

VALUES (35, 'atguigu002');2、实体类

@Data

@AllArgsConstructor

@NoArgsConstructor

public class Payment implements Serializable {

private Long id;

private String serial;

}3、通用返回类

@Data

@NoArgsConstructor

@AllArgsConstructor

public class CommonResult<T>{

private Integer code;

private String message;

private T data;

public CommonResult(Integer code,String message){

this(code,message,null);

}

}4、dao层

@Mapper

public interface PaymentDao {

/**

* 插入操作

* @param payment 实体

* @return 受影响的行数

*/

int create(Payment payment);

/**

* 通过id查订单

* @param id 订单id

* @return 订单

*/

Payment getPaymentById(@Param("id") Long id);

}5、mapper 配置文件类

在resource下,创建mapper/PaymentMapper.xml

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd">

<mapper namespace="com.example.springcloud.dao.PaymentDao">

<resultMap id="BaseResultMap" type="com.example.springcloud.pojo.Payment">

<id column="id" property="id" jdbcType="BIGINT"/>

<id column="serial" property="serial" jdbcType="VARCHAR"/>

</resultMap>

<insert id="create" parameterType="Payment" useGeneratedKeys="true" keyProperty="id">

insert into payment(serial) values (#{serial})

</insert>

<select id="getPaymentById" parameterType="Long" resultMap="BaseResultMap">

select * from payment where id = #{id}

</select>

</mapper>6、写service和serviceImpl

service

public interface PaymentService {

/**

* 插入操作

* @param payment 实体

* @return 受影响的行数

*/

int create(Payment payment);

/**

* 通过id查订单

* @param id 订单id

* @return 订单

*/

Payment getPaymentById(@Param("id") Long id);

}serviceImpl

@Service

public class PaymentServiceImpl implements PaymentService {

@Resource

private PaymentDao paymentDao;

@Override

public int create(Payment payment) {

return paymentDao.create(payment);

}

@Override

public Payment getPaymentById(Long id) {

return paymentDao.getPaymentById(id);

}

}7、controller

@Slf4j

@RestController

@RequiredArgsConstructor(onConstructor_ = @Autowired)

@RequestMapping("/payment")

public class PaymentController {

private final PaymentService paymentService;

@PostMapping("/create")

public CommonResult create(Payment payment){

int result = paymentService.create(payment);

log.info("****插入结果*****:"+result);

if(result > 0){

return new CommonResult(200,"插入数据库成功",result);

}

return new CommonResult(444,"插入数据库失败",result);

}

@PostMapping("/get/{id}")

public CommonResult getPaymentById(@PathVariable("id") Long id){

Payment payment = paymentService.getPaymentById(id);

log.info("****查询结果*****:"+payment);

if(payment != null){

return new CommonResult(200,"查询成功",payment);

}

return new CommonResult(444,"没有对应的记录,查询id"+id);

}

}03、热部署

1.Adding devtools to your project

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>2.Adding plugin to your pom.xml

父类总工程

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<fork>true</fork>

<addResources>true</addResources>

</configuration>

</plugin>

</plugins>

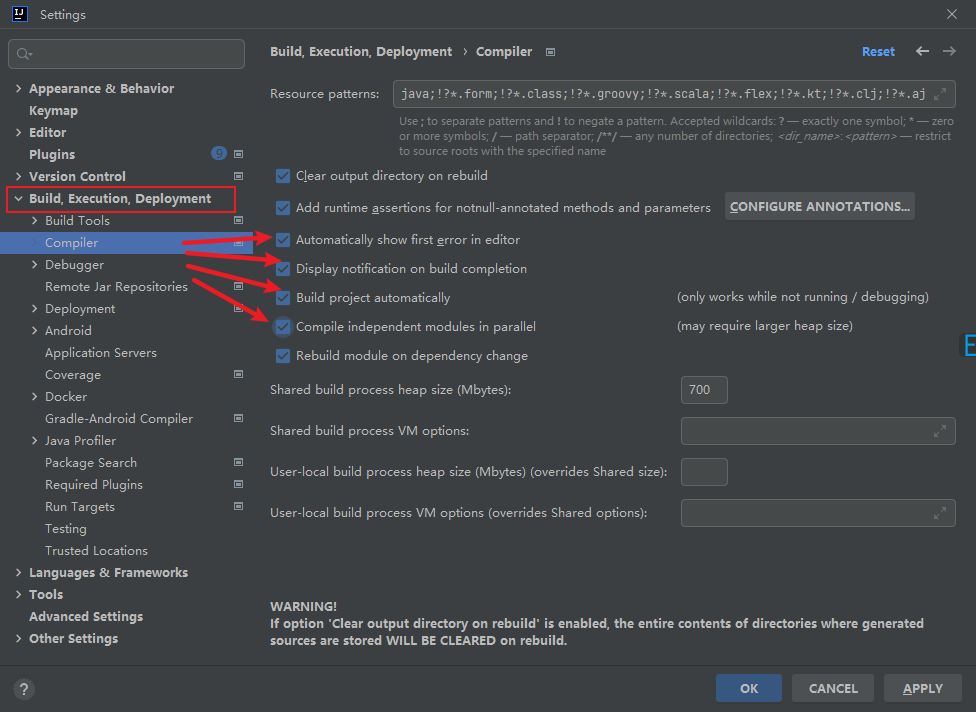

</build>3.Enabling automatic build

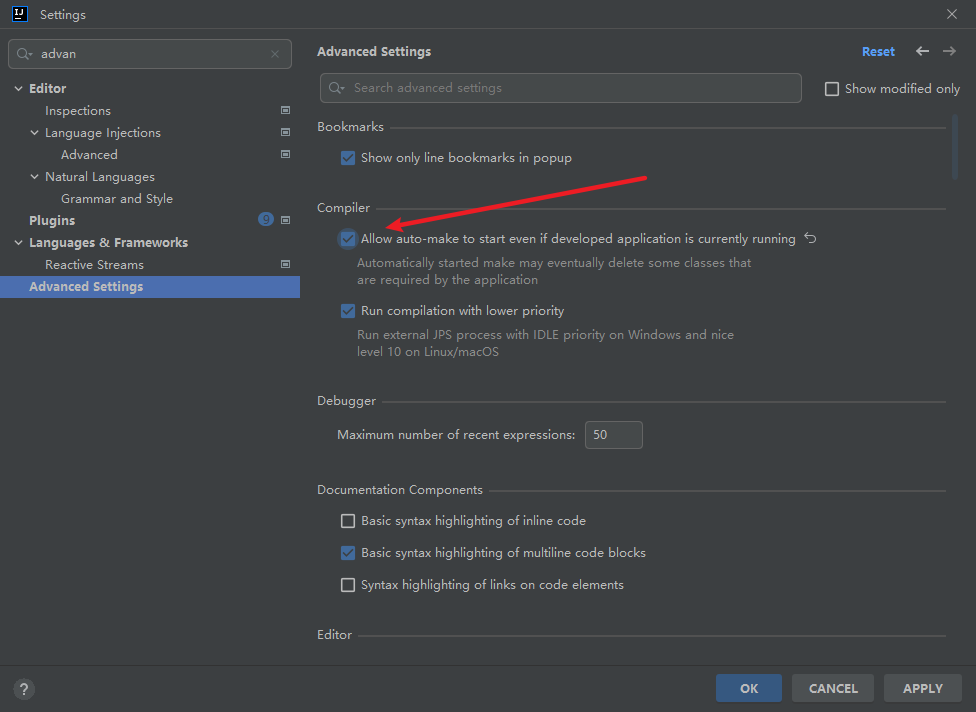

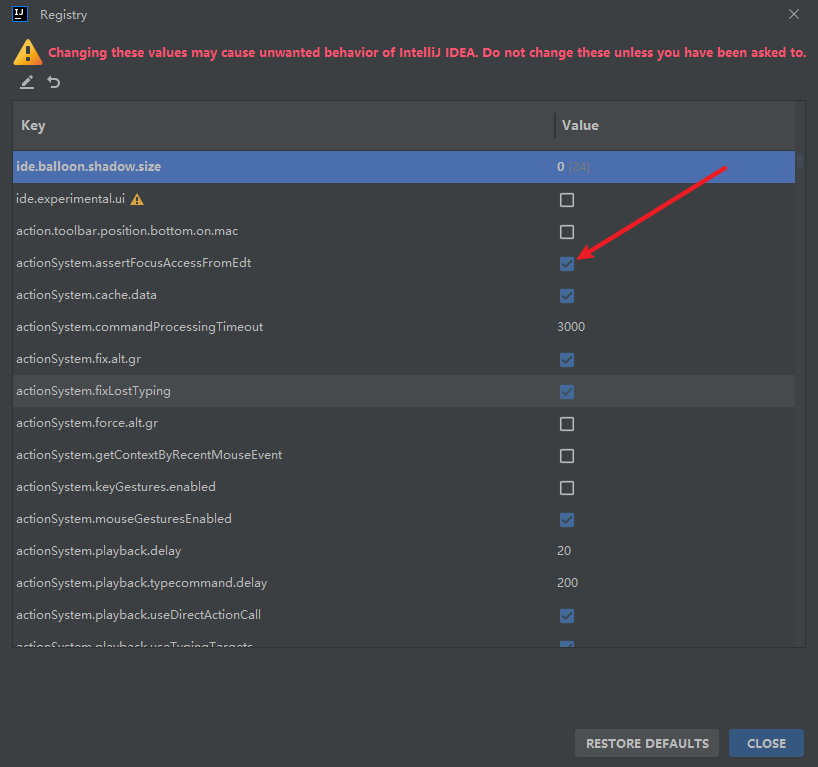

4.Updae the value of

在settings里将此勾选

按ctrl+shift+alt+/ 选择register

将此勾选

5.重启idea

04、order模块

1.pom

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>2.yml配置文件

server:

port: 803.主启动类

@SpringBootApplication

public class OrderMain80 {

public static void main(String[] args) {

SpringApplication.run(OrderMain80.class,args);

}

}4.复制paymant模块的实体类(pojo)

5.写controller层

因为这里是消费者类,主要是消费,那么就没有service和dao,需要调用pay模块的方法

并且这里还没有微服务的远程调用,那么如果要调用另外一个模块,则需要使用基本的api调用

使用RestTemplate调用pay模块

RestTemplate提供了多种便捷访问远程Http服务的方法,是一种简单便捷的访问restful服务模板类,是Spring提供的用于访问Rest服务的客户端模板工具集

使用:

使用restTemplate访问restful接口非常的简单粗暴无脑。(url, requestMap, ResponseBean.class)这三个参数分别代表REST请求地址、请求参数、HTTP响应转成

被转换成的对象类型。

@Slf4j

@RestController

public class OrderController {

public static final String PAYMENT_URL = "http://localhost:8001";

@Resource

private RestTemplate restTemplate;

@GetMapping("/consumer/payment/create")

public CommonResult<Payment> create(Payment payment){

return restTemplate.postForObject(PAYMENT_URL+"/payment/create",payment, CommonResult.class);

}

@GetMapping("/consumer/payment/get/{id}")

public CommonResult<Payment> getPayment(@PathVariable("id") Long id){

return restTemplate.getForObject(PAYMENT_URL+"/payment/get/"+id, CommonResult.class);

}

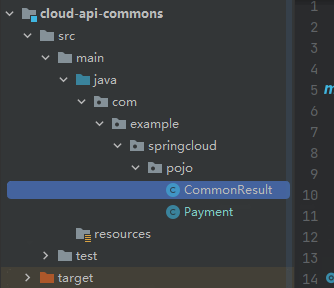

}05、重构

新建一个模块,将重复的代码抽取到一个公共的模块中

1.创建commons模块

2.抽取公共的pom

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>cn.hutool</groupId>

<artifactId>hutool-all</artifactId>

<version>5.7.22</version>

</dependency>

</dependencies>3.pojo类放入到commons中

4.使用maven,将commons打包(install)

其他模块删除pojo,引入commons

<dependency>

<groupId>org.example</groupId>

<artifactId>cloud-api-commons</artifactId>

<version>1.0-SNAPSHOT</version>

</dependency>服务注册与发现

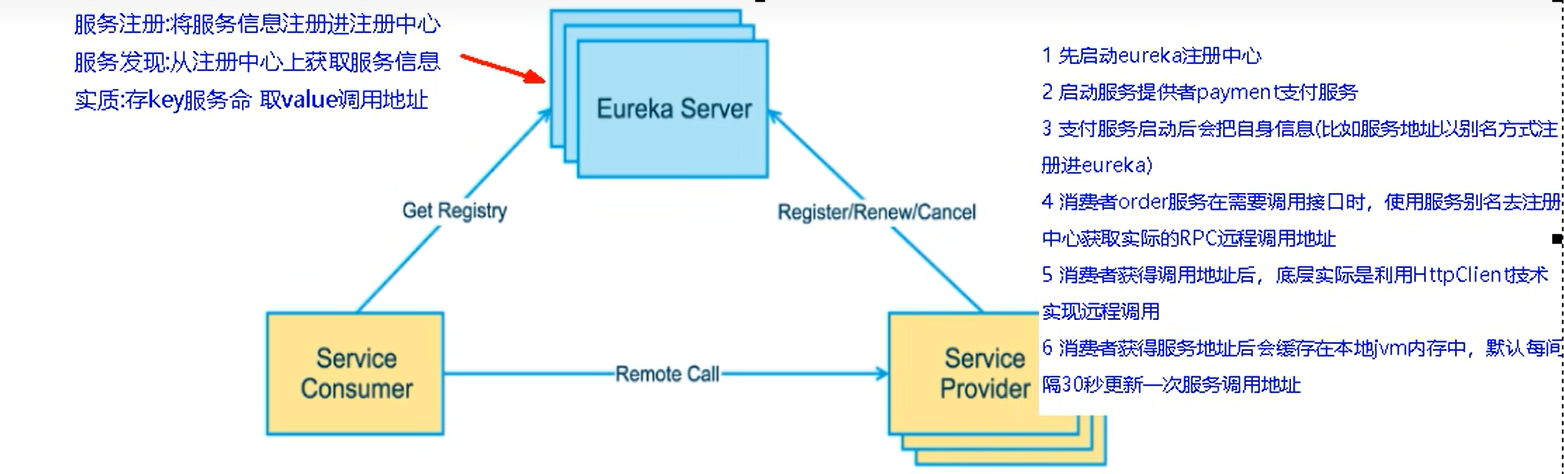

前面我们没有服务注册中心,也可以服务间调用,为什么还要服务注册?

当服务很多时,单靠代码手动管理是很麻烦的,需要一个公共组件,统一管理多服务,包括服务是否正常运行,等

Eureka用于==服务注册==,目前官网已经停止更新

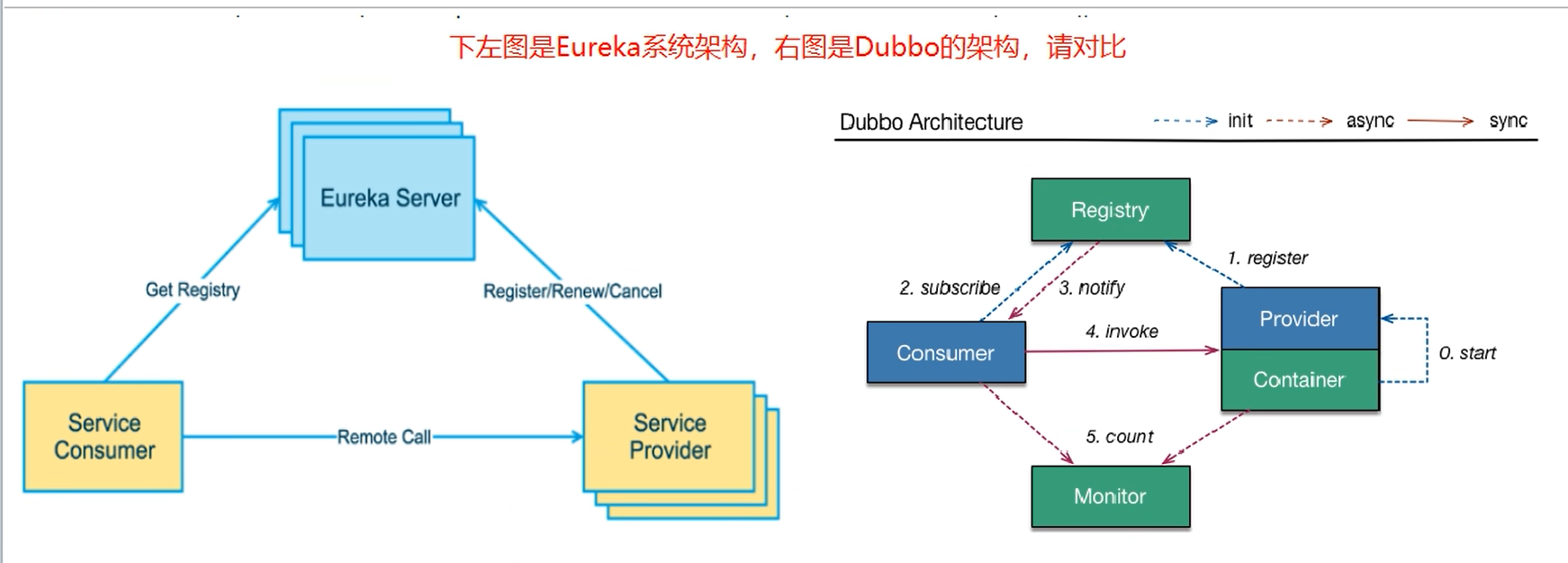

1、Eureka

服务治理

Spring Cloud封装了Netflix 公司开发的Eureka模块来实现服务治理

在传统的rpc远程调用框架中,管理每个服务与服务之间依赖关系比较复杂,管理比较复杂,所以需要使用服务治理,管理服务于服务之间依赖关系,可以实现

服务调用、负载均衡、容错等,实现服务发现与注册。

服务注册

Eureka采用了CS的设计架构,Eureka sever作为服务注册功能的服务器,它是服务注册中心。而系统中的其他做服务,使用 fureka的客户端连接到Eureka

Server并维持心跳连接。这样系统的维护人员就可以通过Eureka Server来监控系统中各个微服务是否正常运行。

在服务注册与发现中,有一个注册中心。当服务器启动的时候,会把当前自己服务器的信息,比如:服务地址通讯地址等以别名方式注册到注册中心上。另一方(消费者 | 服务提供者),以该别名的方式去注册中心上获取到实际的服务通讯地址,然后再实现本地RPC调用

RPC远程调用框架核心设计思想:在于注册中心,因为使用注册中心管理每个服务与服务之间的一个依赖关系(服务治理概念)。在任何rpc远程框架中,都会有一个注册中心(存放服务地址相关信息(接口地址)

Eureka的两个组件:

Eureka Server

Eureka Server 提供服务注册服务

各个微服务节点通过配置启动后,会在EurekaServer中进行注册,这样EurekaServer中的服务注册表中将会存储所有可用服务节点的信息,服务节点的信息可以

在界面中直观看到。

Eureka Client

Eureka Client 通过注册中心进行访问

是一个Java客户端,用于简化Eureka Server的交互,客户端同时也具备一个内置的、使用轮询(round-robin)负载算法的负载均衡器。在应用启动后,将会向

Eureka Server发送心跳(默认周期为30秒)。如果Eureka Server在多个心跳周期内没有接收到某个节点的心跳,EurekaServer将会从服务注册表中把这个服务节点

移除(默认90秒)

单机版

EurekaServer端服务注册中心类似物业中心

EurekaClient端cloud-provider-payment8001将注册进EurekaServer 成为服务提供者provider

EurekaClient端cloud-consumer-order80将注册进EurekaServer 成为服务消费者consumer

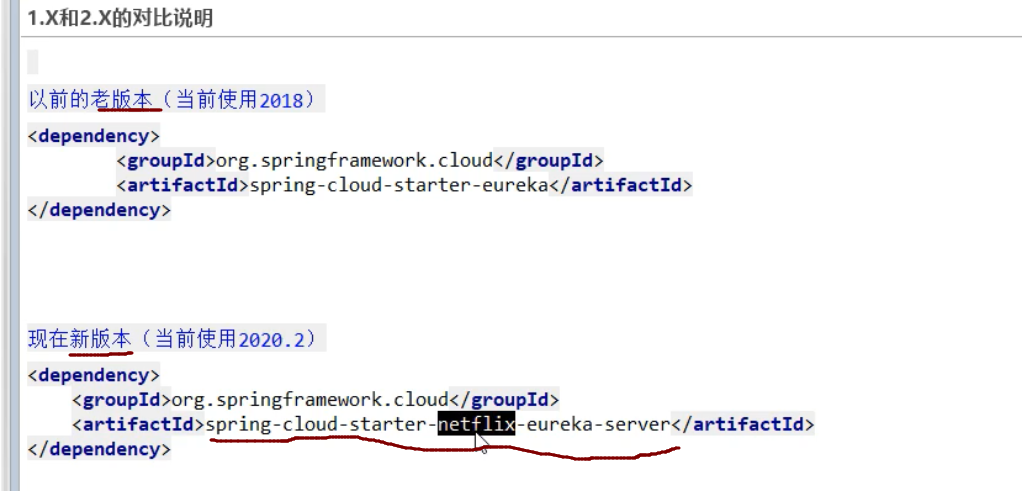

1.创建cloud-eureka-server7001

2引入pom依赖

eureka最新的依赖变了

3.配置文件

server:

port: 7001

# 单机版

eureka:

instance:

hostname: localhost #eureka服务端的实例名字

client:

register-with-eureka: false #表示不向注册中心注册自己

fetch-registry: false #表示自己就是注册中心,职责是维护服务实例,并不需要去检索服务

service-url:

#设置与eureka server交互的地址查询服务和注册服务都需要依赖这个地址

defaultZone: http://${eureka.instance.hostname}:${server.port}/eureka/4.主启动类

@SpringBootApplication

@EnableEurekaServer

public class EurekaMain7001 {

public static void main(String[] args) {

SpringApplication.run(EurekaMain7001.class,args);

}

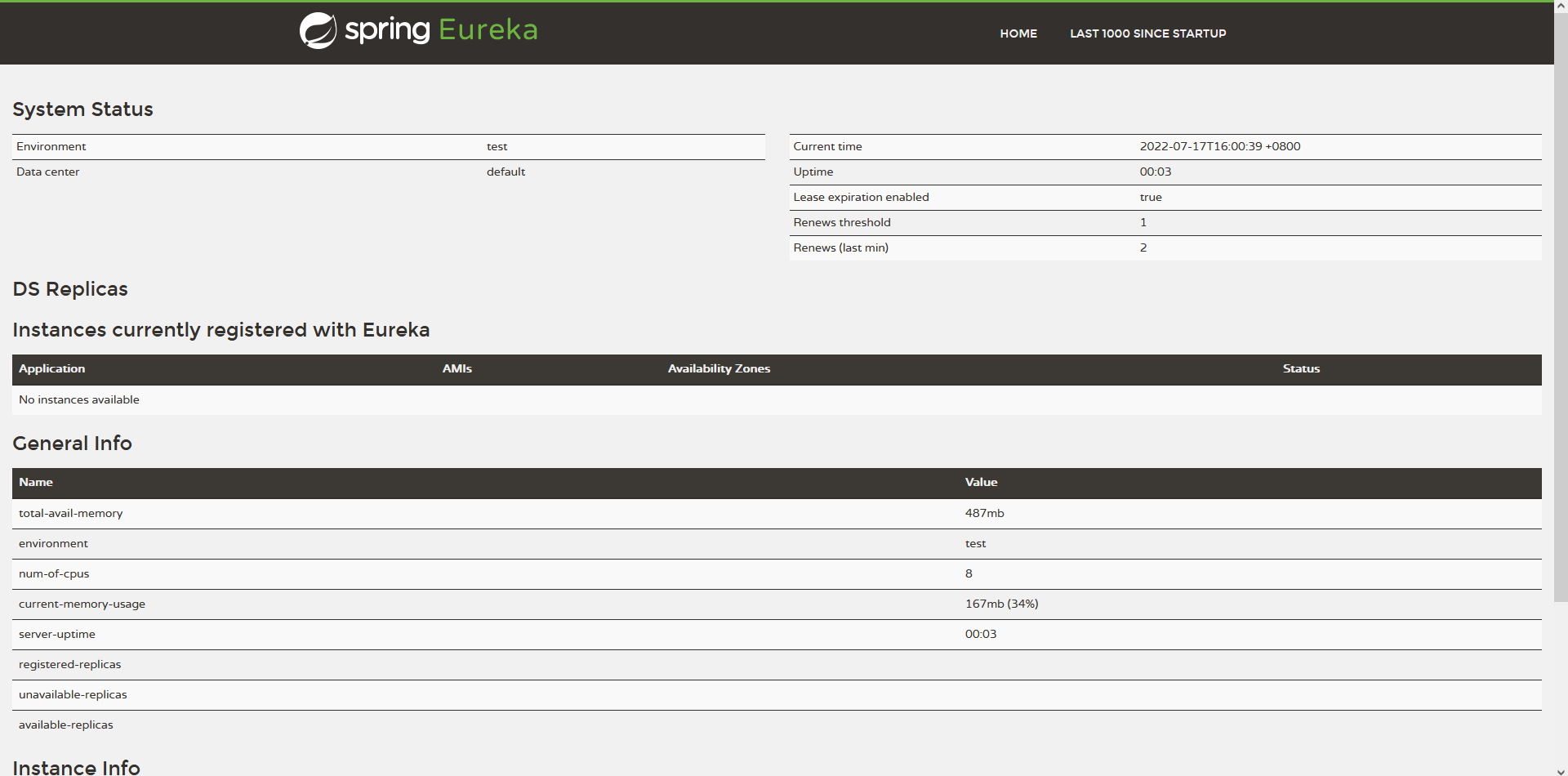

}5.此时就可以启动当前项目了

浏览器输入:localhost:7001

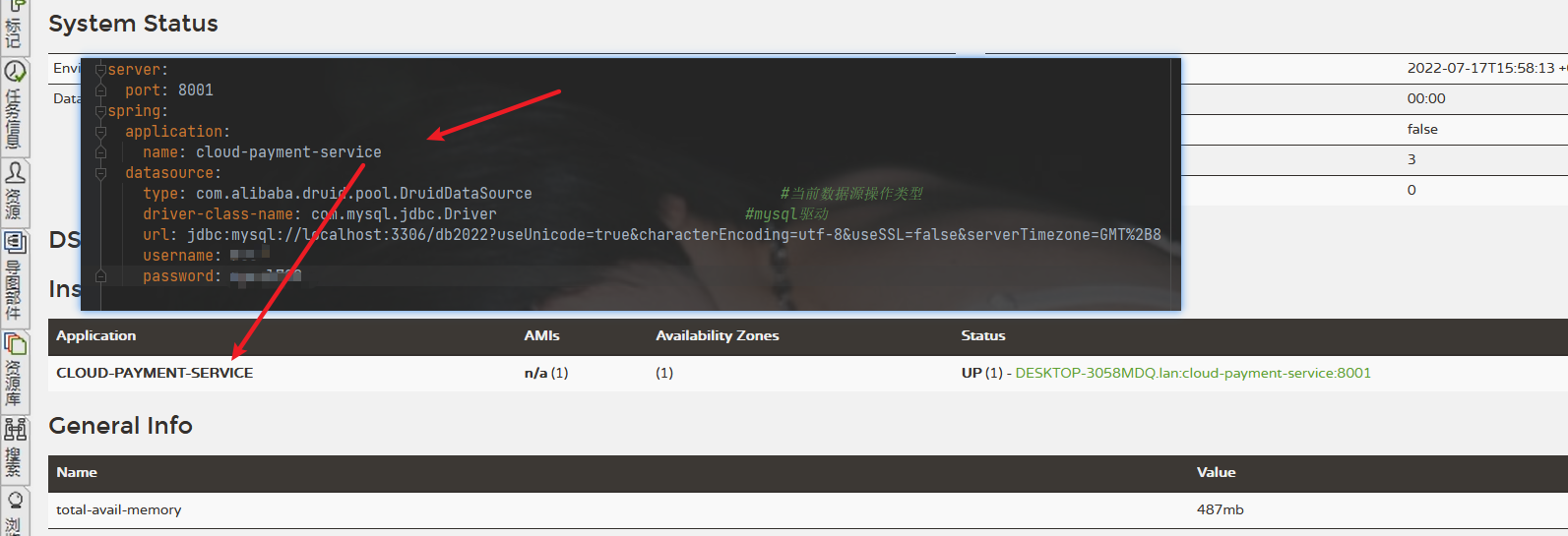

6.其他服务注册到eureka

将payment模块加入eureka

1.在pom中添加依赖

<!--Eureka-client-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>2.主启动类上,加注解。表示当前是eureka客户端

@SpringBootApplication

@EnableEurekaClient

public class PaymentMain8001 {

public static void main(String[] args) {

SpringApplication.run(PaymentMain8001.class, args);

}

}3.修改yml

eureka:

client:

# 表示是否将自己注册进EurekaServer 默认为true

register-with-eureka: true

# 是否从EurekaServer 抓取已有的注册信息。默认为true。单节点无所谓,集群必须设置为true才能配合ribbon 使用负载均衡

fetch-registry: true

service-url:

defaultZone: http://localhost:7001/eureka重启

成功注册

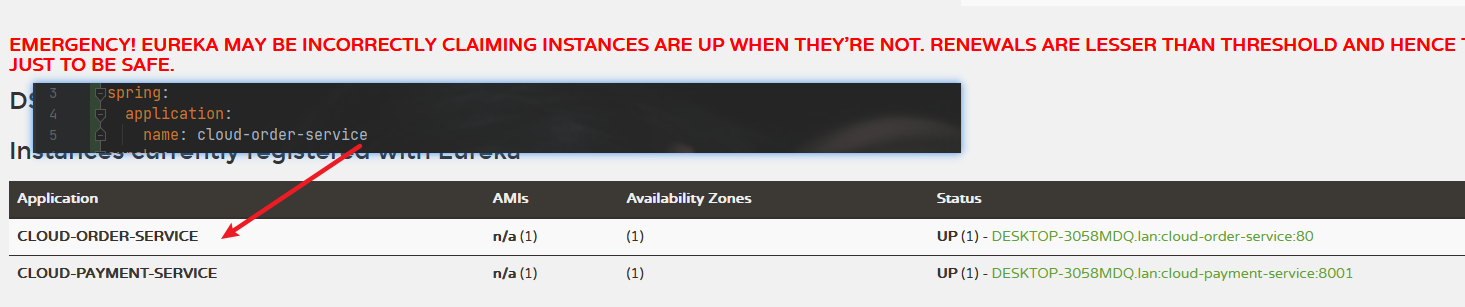

将order模块加入eureka

1.在pom中添加依赖

<!--Eureka-client-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>2.主启动类上,加注解。表示当前是eureka客户端

@SpringBootApplication

@EnableEurekaClient

public class OrderMain80 {

public static void main(String[] args) {

SpringApplication.run(OrderMain80.class,args);

}

}3.修改yml

spring:

application:

name: cloud-order-service

eureka:

client:

# 表示是否将自己注册进EurekaServer 默认为true

register-with-eureka: true

# 是否从EurekaServer 抓取已有的注册信息。默认为true。单节点无所谓,集群必须设置为true才能配合ribbon 使用负载均衡

fetch-registry: true

service-url:

defaultZone: http://localhost:7001/eureka重启

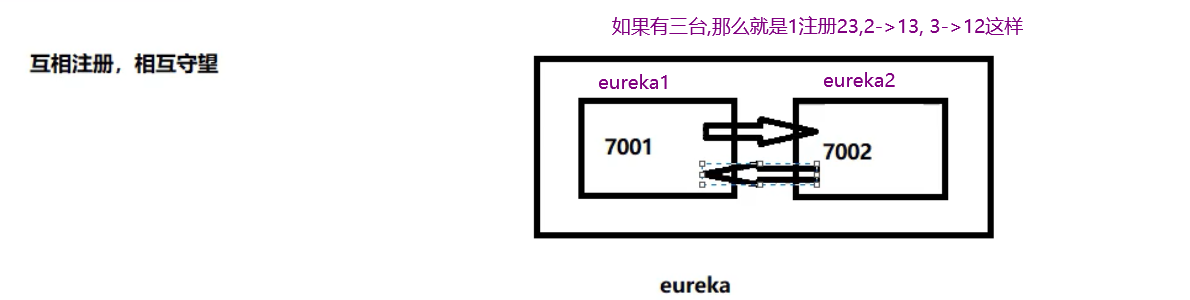

集群

集群原理:

1,就是pay模块启动时,注册自己,并且自身信息也放入eureka

2.order模块,首先也注册自己,放入信息,当要调用pay时,先从eureka拿到pay的调用地址

3.通过HttpClient调用

并且还会缓存一份到本地,每30秒更新一次高可用:如果只有一个注册中心,出故障整个系统就瘫痪了。会导致整个微服务环境不可用。

解决办法:搭建Eureka注册中心集群,实现负载均衡+故障容错。

集群搭建原理:

互相注册

构建新erueka项目

cloud-eureka-server7002

1.pom文件

和7001一样即可

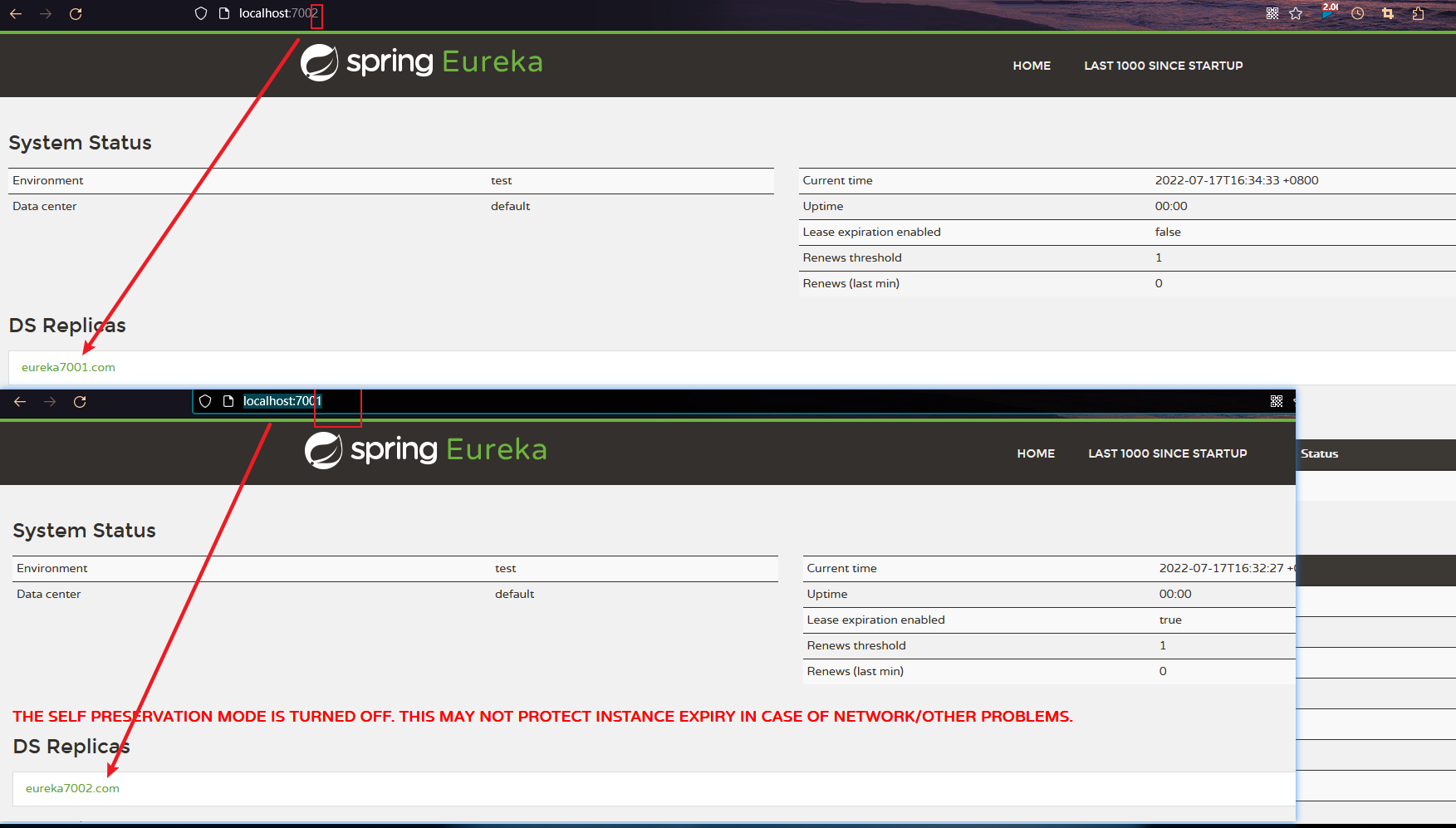

2.配置文件

在写配置文件之前,修改本机的hosts文件(C:\Windows\System32\drivers\etc)

# eureka

127.0.0.1 eureka7001.com

127.0.0.1 eureka7002.com

127.0.0.1 eureka7003.com首先修改之前的7001的eureka项目,因为多个eureka需要互相注册

server:

port: 7001

#集群版

eureka:

instance:

hostname: eureka7001.com #eureka服务端的实例名字

client:

register-with-eureka: false #表示不向注册中心注册自己

fetch-registry: false #表示自己就是注册中心,职责是维护服务实例,并不需要去检索服务

service-url:

#设置与eureka server交互的地址查询服务和注册服务都需要依赖这个地址

# defaultZone: http://eureka7001.com:7001/eureka/

defaultZone: http://eureka7002.com:7002/eureka/ #这个是集群版开启 互相注册修改7002

server:

port: 7002

#集群版

eureka:

instance:

hostname: eureka7002.com #eureka服务端的实例名字

client:

register-with-eureka: false #表示不向注册中心注册自己

fetch-registry: false #表示自己就是注册中心,职责是维护服务实例,并不需要去检索服务

service-url:

#设置与eureka server交互的地址查询服务和注册服务都需要依赖这个地址

# defaultZone: http://eureka7002.com:7002/eureka/

defaultZone: http://eureka7001.com:7001/eureka/ #这个是集群版开启 互相注册3,主启动类:

复制7001的即可

4,然后启动7001,7002即可

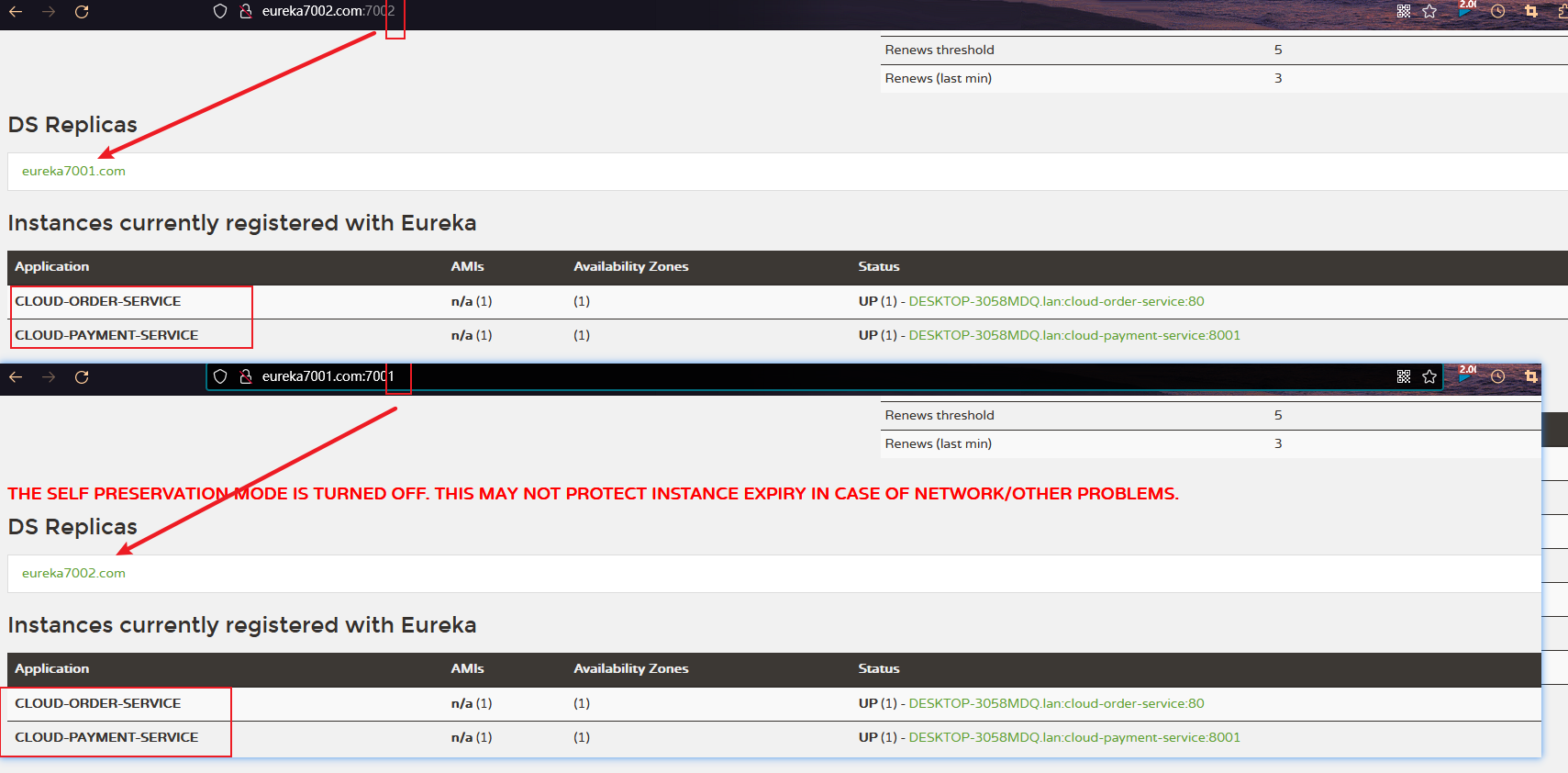

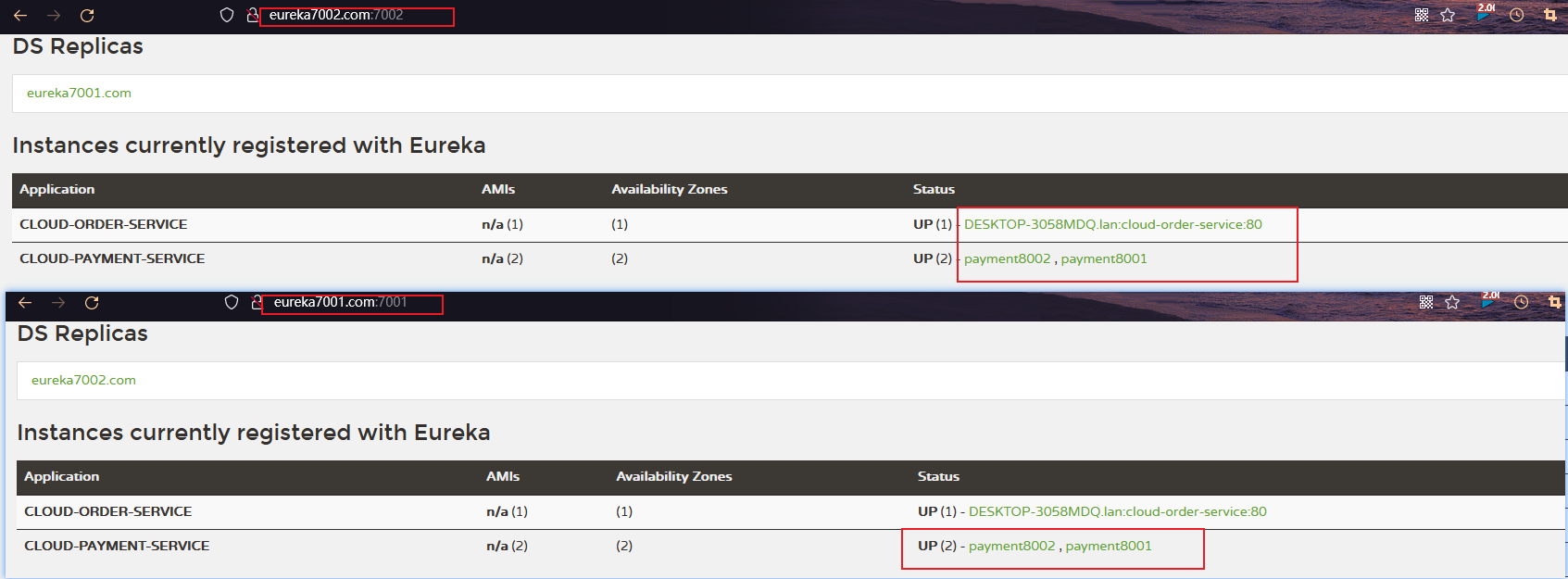

将pay,order模块注册到eureka集群中:

1,只需要修改配置文件即可:

eureka:

client:

# 表示是否将自己注册进EurekaServer 默认为true

register-with-eureka: true

# 是否从EurekaServer 抓取已有的注册信息。默认为true。单节点无所谓,集群必须设置为true才能配合ribbon 使用负载均衡

fetch-registry: true

service-url:

# defaultZone: http://localhost:7001/eureka # 单机版

defaultZone: http://eureka7001.com:7001/eureka,http://eureka7002.com:7002/eureka # 集群版2,两个模块都修改上面的都一样即可

然后启动两个模块

要先启动7001,7002,然后是pay模块8001,然后是order(80)

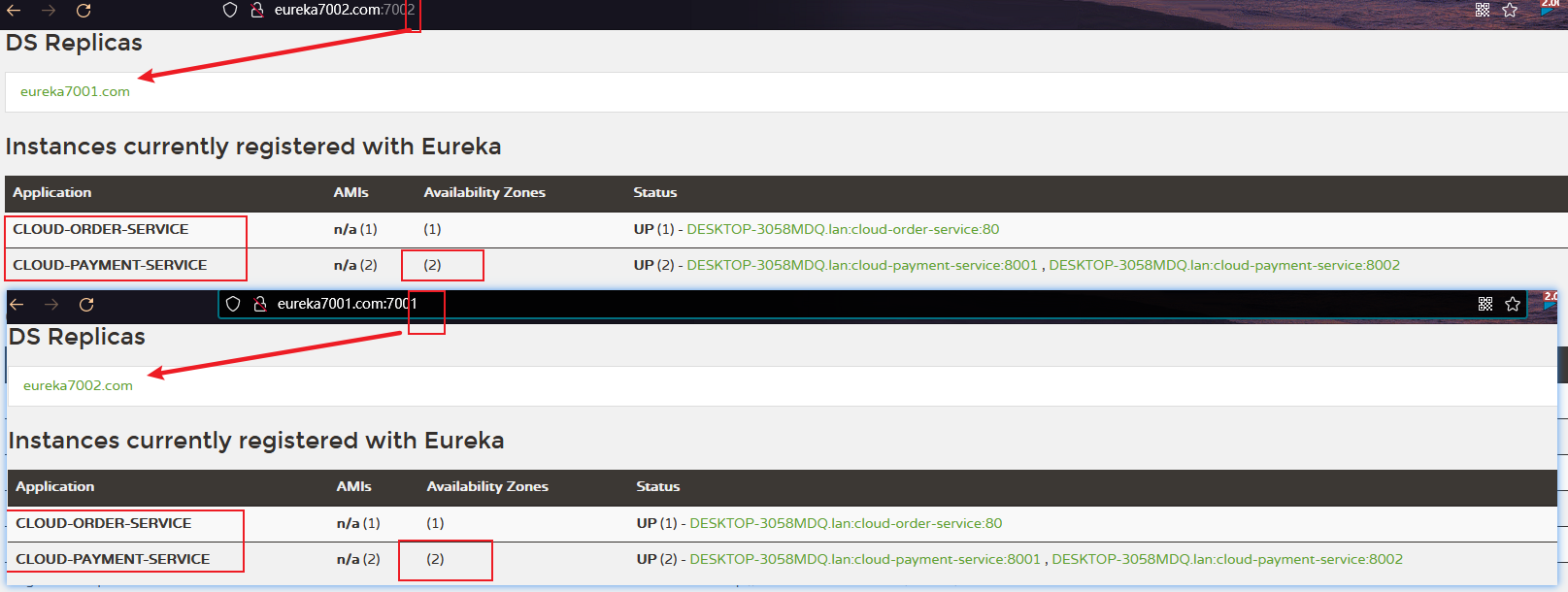

将payment模块也配置为集群模式

1,创建新模块,8002

名称: cloud-provider-payment8002

2.pom文件

复制8001的

3,yml配置文件

复制8001的

端口修改成8002

服务名称不用改,用一样的

4.主启动类

复制8001的

修改为8002

5,mapper,service,controller都复制一份

为了区分,分别打印端口号:

@Slf4j

@RestController

@RequestMapping("/payment")

public class PaymentController {

@Autowired

private PaymentService paymentService;

@Value("${server.port}")

private String servicePort;

@PostMapping("/create")

public CommonResult<Payment> create(@RequestBody Payment payment){

int result = paymentService.create(payment);

log.info("****插入结果*****:"+result);

if(result > 0){

return new CommonResult(200,"插入数据库成功,serverPort: "+servicePort,result);

}

return new CommonResult(444,"插入数据库失败",result);

}

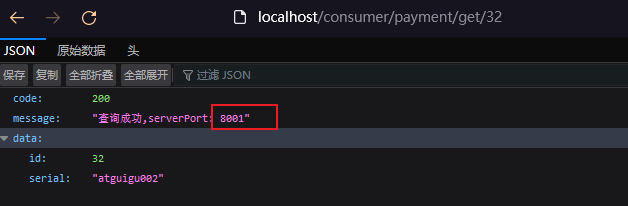

@GetMapping("/get/{id}")

public CommonResult<Payment> getPaymentById(@PathVariable("id") Long id){

Payment payment = paymentService.getPaymentById(id);

if(payment != null){

return new CommonResult(200,"查询成功,serverPort: "+servicePort,payment);

}

return new CommonResult(444,"没有对应的记录,查询id"+id);

}

}然后就启动服务即可

此时访问order模块,发现并没有负载均衡到两个pay,模块中,而是只访问8001

虽然我们是使用RestTemplate访问的微服务,但是也可以负载均衡的

修改order80的访问地址

//public static final String PAYMENT_URL = "http://localhost:8001";

public static final String PAYMENT_URL = "http://CLOUD-PAYMENT-SERVICE";注意这样还不行,需要让RestTemplate开启负载均衡注解,还可以指定负载均衡算法,默认轮询

修改RestTemplate的配置 添加@LoadBalanced

@Configuration

public class ApplicationContextConfig {

@Bean

@LoadBalanced

public RestTemplate getRestTemplate(){

return new RestTemplate();

}

}Ribben和Eureka 整合后Consumer可以直接调用服务而不用再关心地址和端口号,且改该服务还有负载能力了。

修改服务主机名和ip在eureka的web上显示

修改服务主机名

修改yml配置文件

添加instance.instance-id

eureka:

client:

# 表示是否将自己注册进EurekaServer 默认为true

register-with-eureka: true

# 是否从EurekaServer 抓取已有的注册信息。默认为true。单节点无所谓,集群必须设置为true才能配合ribbon 使用负载均衡

fetch-registry: true

service-url:

# defaultZone: http://localhost:7001/eureka # 单机版

defaultZone: http://eureka7001.com:7001/eureka,http://eureka7002.com:7002/eureka # 集群版

instance:

instance-id: payment8001同样的修改8002的

添加ip显示

修改yml配置文件

添加instance.prefer-ip-address

eureka:

client:

# 表示是否将自己注册进EurekaServer 默认为true

register-with-eureka: true

# 是否从EurekaServer 抓取已有的注册信息。默认为true。单节点无所谓,集群必须设置为true才能配合ribbon 使用负载均衡

fetch-registry: true

service-url:

# defaultZone: http://localhost:7001/eureka # 单机版

defaultZone: http://eureka7001.com:7001/eureka,http://eureka7002.com:7002/eureka # 集群版

instance:

instance-id: payment8001

prefer-ip-address: true # 访问路径可以显示IP地址同样的修改8002的

服务发现

对于注册进eureka里面的微服务,可以通过服务发现来获得该服务的信息

以payment模块为例

1,引入DiscoveryClient

在controller里面

@Slf4j

@RestController

@RequestMapping("/payment")

public class PaymentController {

@Autowired

private PaymentService paymentService;

@Value("${server.port}")

private String servicePort;

@Resource

private DiscoveryClient discoveryClient;

@GetMapping("/discovery")

public Object discovery(){

List<String> services = discoveryClient.getServices();

for (String element : services) {

log.info("*****element: "+element);

}

List<ServiceInstance> instances = discoveryClient.getInstances("CLOUD-PAYMENT-SERVICE");

for (ServiceInstance instance : instances) {

log.info("instance:"+instance.getInstanceId()+"\t"+instance.getHost()+"\t"+instance.getPort()+"\t"+instance.getUri());

}

return this.discoveryClient;

}

}2,在主启动类上添加一个注解

@EnableDiscoveryClient

@SpringBootApplication

@EnableEurekaClient

@EnableDiscoveryClient

public class PaymentMain8001 {

public static void main(String[] args) {

SpringApplication.run(PaymentMain8001.class, args);

}

}然后重启8001。访问/payment/discovery

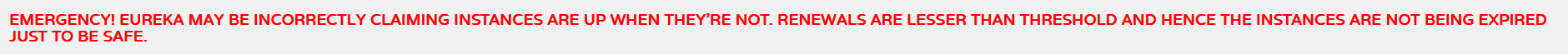

Eureka的自我保护机制

自我保护机制原理

保护模式主要用于一组客户端和Eureka Server之间存在网络分区场景下的保护。

一旦进入保护模式,Eureka Server将会尝试保护其服务注册表中的信息,不再删除服务注册表中的数据,也就是不会注销任何微服务。

如果在Eureka Server的首页看到以下这段提示,则说明Eureka进入了保护模式:

即:某时刻某一个微服务不可用了。Eureka不会立刻清理,依旧会对该微服务的信息进行保存。(属于CAP里面的AP分支)

- 为什么会产生Eureka自我保护机制?

为了防lEurekaClient可以正常运行,但是与EurekaServer网络不通情况下,EurekaServer不会立刻将EurekaClient服务剔除

- 什么是自我保护机制?

默认情况下,如果EurekaServer在一定时间内没有接收到某个微服务实例的心跳,EurekaServer将会注销该实例(默认90秒)。但是当网络分区故障发生(延时、卡

顿、拥挤)时,微服务与EurekaServer之间无法正常通信,以上行为可能变得非常危险了——因为微服务本身其实是健康的,此时本不应该注销这个微服务。

Eureka通过“自我保护模式”来解决这个问题——当EurekaServer节点在短时间内丢失过多客户端时(可能发生了网络分区故障),那么这个节点就会进入自我保护模

式。

总结:

在自我保护模式中,Eureka Server会保护服务注册表中的信息,不再注销任何服务实例。它的设计哲学就是宁可保留错误的服务注册信息,也不盲目注销任何可能健康的服务实例。一句话讲解:好死不如赖活着

综上,自我保护模式是一种应对网络异常的安全保护措施。它的架构哲学是宁可同时保留所有微服务(健康的微服务和不健康的微服务都会保留))也不盲目注销

任何健康的微服务。使用自我保护模式,可以让Eureka集群更加的健壮、稳定。

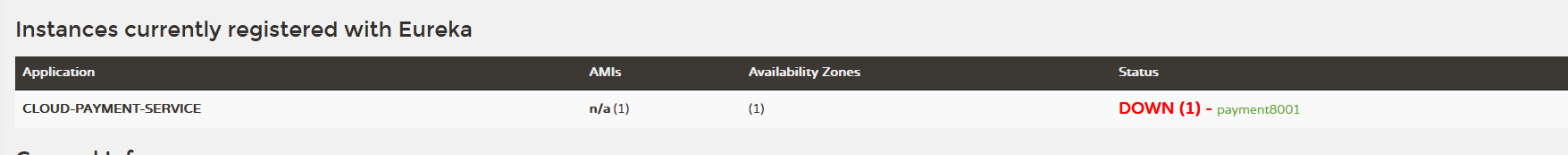

禁止自我保护

以7001和8001为例

修改7001的yml:

eureka:

instance:

hostname: eureka7001.com #eureka服务端的实例名字

client:

register-with-eureka: false #表示不向注册中心注册自己

fetch-registry: false #表示自己就是注册中心,职责是维护服务实例,并不需要去检索服务

service-url:

#设置与eureka server交互的地址查询服务和注册服务都需要依赖这个地址

defaultZone: http://eureka7001.com:7001/eureka/

# defaultZone: http://eureka7002.com:7002/eureka/ #这个是集群版开启 互相注册 集群就是指向其他的eureka

server:

# 关闭自我保护机制,保证不可用服务被及时踢除

enable-self-preservation: false

eviction-interval-timer-in-ms: 2000修改8001的yml

eureka:

client:

# 表示是否将自己注册进EurekaServer 默认为true

register-with-eureka: true

# 是否从EurekaServer 抓取已有的注册信息。默认为true。单节点无所谓,集群必须设置为true才能配合ribbon 使用负载均衡

fetch-registry: true

service-url:

# defaultZone: http://localhost:7001/eureka # 单机版

defaultZone: http://eureka7001.com:7001/eureka,http://eureka7002.com:7002/eureka # 集群版

instance:

instance-id: payment8001

prefer-ip-address: true # 访问路径可以显示IP地址

# Eureka 客户端向服务端发送心跳的时间间隔,单位为秒(默认为30秒)

lease-renewal-interval-in-seconds: 1

# Eureka 客户端在收到最后一次心跳后等待的时间上限,单位为秒(默认为90秒),超时将剔除服务

lease-expiration-duration-in-seconds: 2先关闭8001

此时启动erueka和pay.此时如果直接关闭了pay,那么erueka会直接删除其注册信息

2、Zookeeper

zookeeper是一个分布式协调工具,可以实现注册中心功能

关闭Linux服务器防火墙后启动zookeeper服务器

Zookeeper服务器取代Eureka服务器,zk作为服务注册中心

1.安装zookeeper并启动

2.创建新的pay模块

单独用于注册到zk中

名字:cloud-provider-zookeeper-payment8004

1.pom依赖

<dependencies>

<!--springboot 整合 zookeeper 客户端-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-zookeeper-discovery</artifactId>

</dependency>

<dependency>

<groupId>org.example</groupId>

<artifactId>cloud-api-commons</artifactId>

<version>${project.version}</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

</dependency>

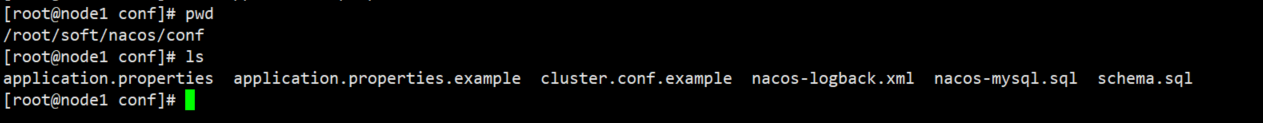

</dependencies>2.yml配置文件

# 8004 表示注册到zookeeper服务器的支付服务提供者端口号

server:

port: 8004

# 服务别名----注册到zookeeper 到注册中心的名称

spring:

application:

name: cloud-provider-payment

cloud:

zookeeper:

connect-string: 192.168.160.128:21813,主启动类

@SpringBootApplication

// 该注解用于向使用consul或者zookeeper 作为注册中心时的注册服务

@EnableDiscoveryClient

public class PaymentMain8004 {

public static void main(String[] args) {

SpringApplication.run(PaymentMain8004.class,args);

}

}4,controller

@Slf4j

@RestController

@RequestMapping("/payment")

public class PaymentController {

@Value("${server.port}")

private String serverPort;

@RequestMapping("/zk")

public String paymentZk(){

return "Springcloud with zookeeper: "+serverPort +"\t"+ UUID.randomUUID();

}

}5,启动

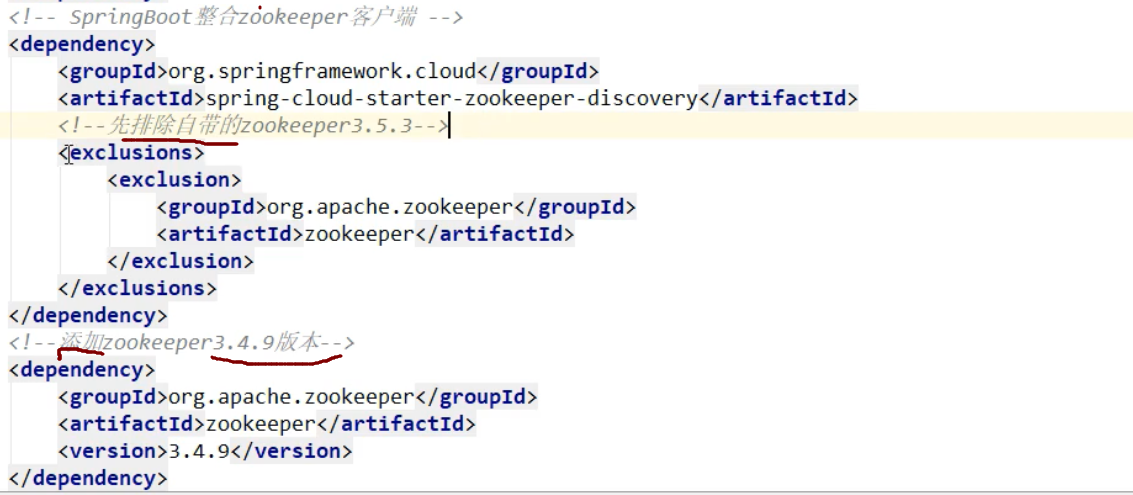

此时启动,会报错,因为jar包与我们的zk版本不匹配

修改pom文件,改成与我们zk相匹配的jar包

eg:

再次重启:

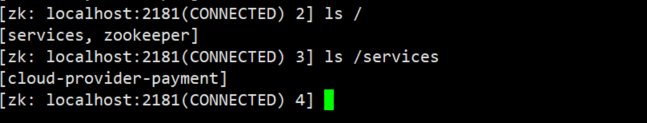

此时8004就已经注册到zk中了。

6.测试

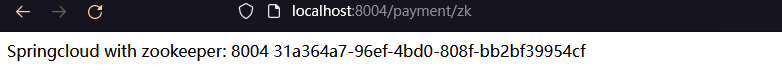

- 验证测试:浏览器 - http://localhost:8004/payment/zk

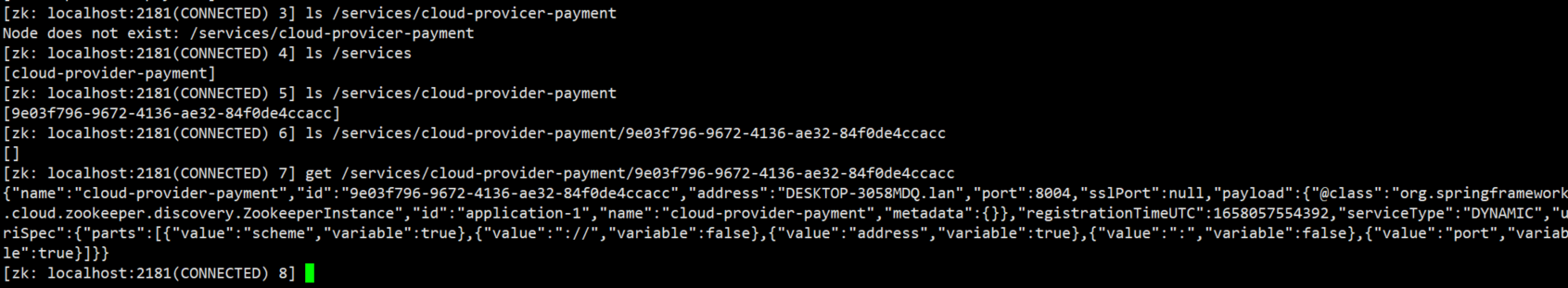

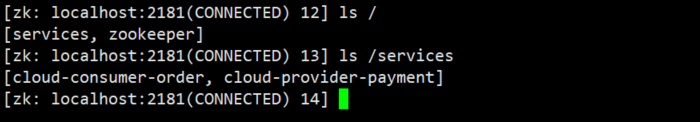

- 验证测试2 :接着用zookeeper客户端操作

[zk: localhost:2181(CONNECTED) 5] ls /services/cloud-provider-payment

[9e03f796-9672-4136-ae32-84f0de4ccacc]

[zk: localhost:2181(CONNECTED) 6] ls /services/cloud-provider-payment/9e03f796-9672-4136-ae32-84f0de4ccacc

[]

[zk: localhost:2181(CONNECTED) 7] get /services/cloud-provider-payment/9e03f796-9672-4136-ae32-84f0de4ccacc

{"name":"cloud-provider-payment","id":"9e03f796-9672-4136-ae32-84f0de4ccacc","address":"DESKTOP-3058MDQ.lan","port":8004,"sslPort":null,"payload":{"@class":"org.springframework.cloud.zookeeper.discovery.ZookeeperInstance","id":"application-1","name":"cloud-provider-payment","metadata":{}},"registrationTimeUTC":1658057554392,"serviceType":"DYNAMIC","uriSpec":{"parts":[{"value":"scheme","variable":true},{"value":"://","variable":false},{"value":"address","variable":true},{"value":":","variable":false},{"value":"port","variable":true}]}}json格式化get /services/cloud-provider-payment/a4567f50-6ad9-47a3-9fbb-7391f41a9f3d的结果:

{

"name": "cloud-provider-payment",

"id": "9e03f796-9672-4136-ae32-84f0de4ccacc",

"address": "DESKTOP-3058MDQ.lan",

"port": 8004,

"sslPort": null,

"payload": {

"@class": "org.springframework.cloud.zookeeper.discovery.ZookeeperInstance",

"id": "application-1",

"name": "cloud-provider-payment",

"metadata": {}

},

"registrationTimeUTC": 1658057554392,

"serviceType": "DYNAMIC",

"uriSpec": {

"parts": [

{

"value": "scheme",

"variable": true

},

{

"value": "://",

"variable": false

},

{

"value": "address",

"variable": true

},

{

"value": ":",

"variable": false

},

{

"value": "port",

"variable": true

}

]

}

}ZooKeeper的服务节点是临时节点,没有Eureka那含情脉脉。

3.创建order消费模块注册到zk

1,创建项目

名字: cloud-consum-zookeeper-order80

2,pom

<dependencies>

<!--springboot 整合 zookeeper 客户端-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-zookeeper-discovery</artifactId>

</dependency>

<dependency>

<groupId>org.example</groupId>

<artifactId>cloud-api-commons</artifactId>

<version>${project.version}</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

</dependency>

</dependencies>3,配置文件

server:

port: 80

# 服务别名----注册到zookeeper 到注册中心的名称

spring:

application:

name: cloud-consumer-order

cloud:

zookeeper:

connect-string: 127.0.0.1:2181 # 192.168.160.128:21814,主启动类

@SpringBootApplication

// 该注解用于向使用consul或者zookeeper 作为注册中心时的注册服务

@EnableDiscoveryClient

public class OrderZKMain80 {

public static void main(String[] args) {

SpringApplication.run(OrderZKMain80.class,args);

}

}5,配置类

@Configuration

public class ApplicationContextConfig {

@Bean

@LoadBalanced

public RestTemplate getRestTemplate(){

return new RestTemplate();

}

}6,业务类

@Slf4j

@RestController

@RequestMapping("/payment")

public class OrderZKController {

public static final String INVOKE_URL = "http://cloud-provider-payment";

@Resource

private RestTemplate restTemplate;

@GetMapping(value = "/consumer/payment/zk")

public String paymentInfo()

{

String result = restTemplate.getForObject(INVOKE_URL+"/payment/zk",String.class);

return result;

}

}7,启动

可以发现已经注册

8、集群版的zk注册

只需修改配置文件

这个connect-string指定多个zk地址即可

connect-string: 1.2.3.4,2.3.4.5

3、consul

简介

What is Consul?

Consul is a service mesh solution providing a full featured control plane with service discovery, configuration, and segmentation functionality. Each of these features can be used individually as needed, or they can be used together to build a full service mesh. Consul requires a data plane and supports both a proxy and native integration model. Consul ships with a simple built-in proxy so that everything works out of the box, but also supports 3rd party proxy integrations such as Envoy. link

Consul是一个服务网格解决方案,它提供了一个功能齐全的控制平面,具有服务发现、配置和分段功能。这些特性中的每一个都可以根据需要单独使用,也可以一起用于构建全服务网格。Consul需要一个数据平面,并支持代理和本机集成模型。Consul船与一个简单的内置代理,使一切工作的开箱即用,但也支持第三方代理集成,如Envoy。

基本概念

Consul是一套开源的分布式服务发现和配置管理系统,由HashiCorp公司用Go语言开发。

提供了微服务系统中的服务治理、配置中心、控制总线等功能。这些功能中的每一个都可以根据需要单独使用,也可以一起使用以构建全方位的服务网格,总之

Consul提供了一种完整的服务网格解决方案。

它具有很多优点。包括:基于raft协议,比较简洁;支持健康检查,同时支持HTTP和DNS协议支持跨数据中心的WAN集群提供图形界面跨平台,支持Linux、Mac、Windows

功能

- 服务发现

- 提供http和dns两种发现方式

- 健康检测

- 支持多种方式,http、tcp、docker、shell脚本定制化

- kv存储

- key、value的存储方式

- 多数据中心

- consul支持多数据中心

- 可视化web界面

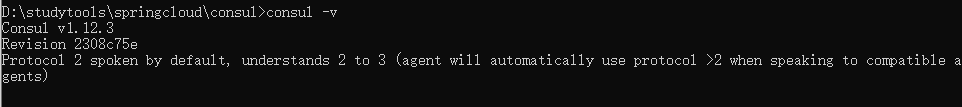

安装并运行consul

windows版解压缩后,得consul.exe,打开cmd

查看版本consul -v :

D:\studytools\springcloud\consul>consul -v

Consul v1.12.3

Revision 2308c75e

Protocol 2 spoken by default, understands 2 to 3 (agent will automatically use protocol >2 when speaking to compatible agents)开发模式启动consul agent -dev:

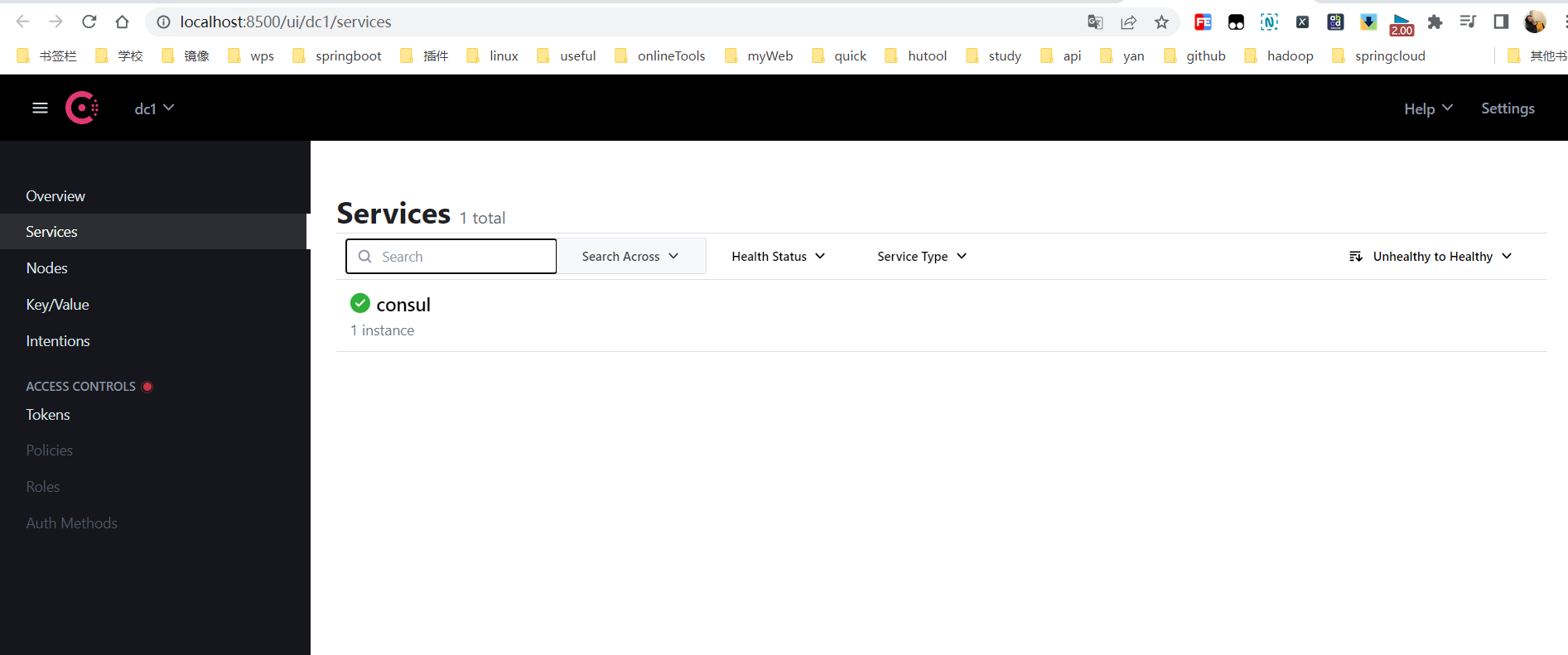

浏览器输入 - http://localhost:8500/ - 打开Consul控制页。

服务提供者注册进consul

1.新建Module支付服务provider8006

名字cloud-provider-consul-payment8006

2.pom依赖

<dependencies>

<!--springboot 整合 consul 客户端-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-consul-discovery</artifactId>

</dependency>

<!-- 引入自己定义的api通用包,可以使用Payment支付Entity -->

<dependency>

<groupId>org.example</groupId>

<artifactId>cloud-api-commons</artifactId>

<version>${project.version}</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

</dependency>

</dependencies>3.yml配置

# consul 服务端口号

server:

port: 8006

spring:

application:

name: cloud-provider-payment

cloud:

# consul注册中心地址

consul:

host: localhost

port: 8500

discovery:

#hostname 127.0.0.1

service-name: ${spring.application.name}4.主启动类

@SpringBootApplication

@EnableDiscoveryClient

public class PaymentMain8006 {

public static void main(String[] args) {

SpringApplication.run(PaymentMain8006.class,args);

}

}5.业务类controller

@Slf4j

@RestController

@RequestMapping("/payment")

public class PaymentController {

@Value("${server.port}")

private String serverPort;

@RequestMapping("/consul")

public String paymentZk(){

return "SpringCloud with consul: "+serverPort +"\t"+ UUID.randomUUID();

}

}6.验证测试

服务消费者注册进consul

1.新建Module消费服务order80

名字cloud-consumer-consul-order80

2.pom依赖

<dependencies>

<!--springboot 整合 consul 客户端-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-consul-discovery</artifactId>

</dependency>

<!-- 引入自己定义的api通用包,可以使用Payment支付Entity -->

<dependency>

<groupId>org.example</groupId>

<artifactId>cloud-api-commons</artifactId>

<version>${project.version}</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

</dependency>

</dependencies>3.yml配置

# consul 服务端口号

server:

port: 80

spring:

application:

name: cloud-consul-order

cloud:

# consul注册中心地址

consul:

host: localhost

port: 8500

discovery:

#hostname 127.0.0.1

service-name: ${spring.application.name}4.主启动类

@SpringBootApplication

@EnableDiscoveryClient

public class PaymentMain8006 {

public static void main(String[] args) {

SpringApplication.run(PaymentMain8006.class,args);

}

}5配置类

@Configuration

public class ApplicationContextConfig {

@Bean

@LoadBalanced

public RestTemplate getRestTemplate(){

return new RestTemplate();

}

}6.业务类controller

@Slf4j

@RestController

@RequestMapping("/consumer")

public class OrderConsulController {

public static final String INVOKE_URL = "http://cloud-provider-payment";

@Resource

private RestTemplate restTemplate;

@GetMapping(value = "/payment/consul")

public String paymentInfo()

{

return restTemplate.getForObject(INVOKE_URL+"/payment/consul",String.class);

}

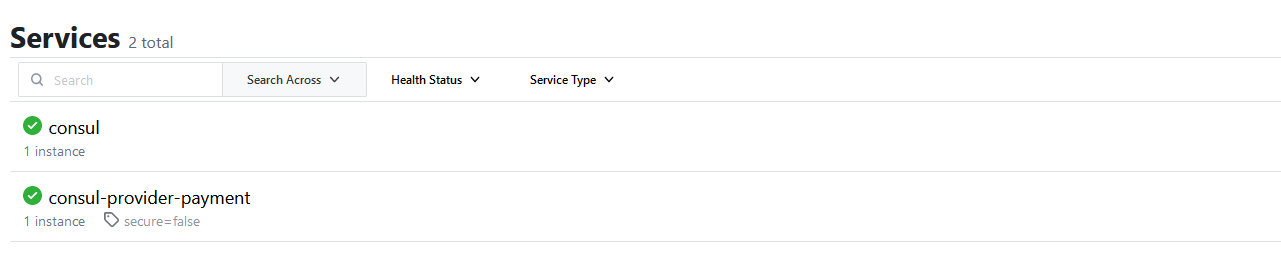

}7.验证测试

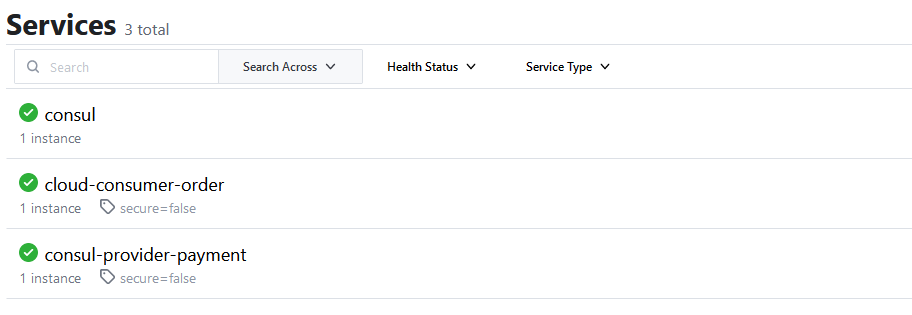

运行consul,cloud-provider-consul-payment8006,cloud-consumer-consul-order80

http://localhost:8500/ 主页会显示出consul,cloud-providerconsul-payment8006,cloud-consumerconsul-order80三服务。

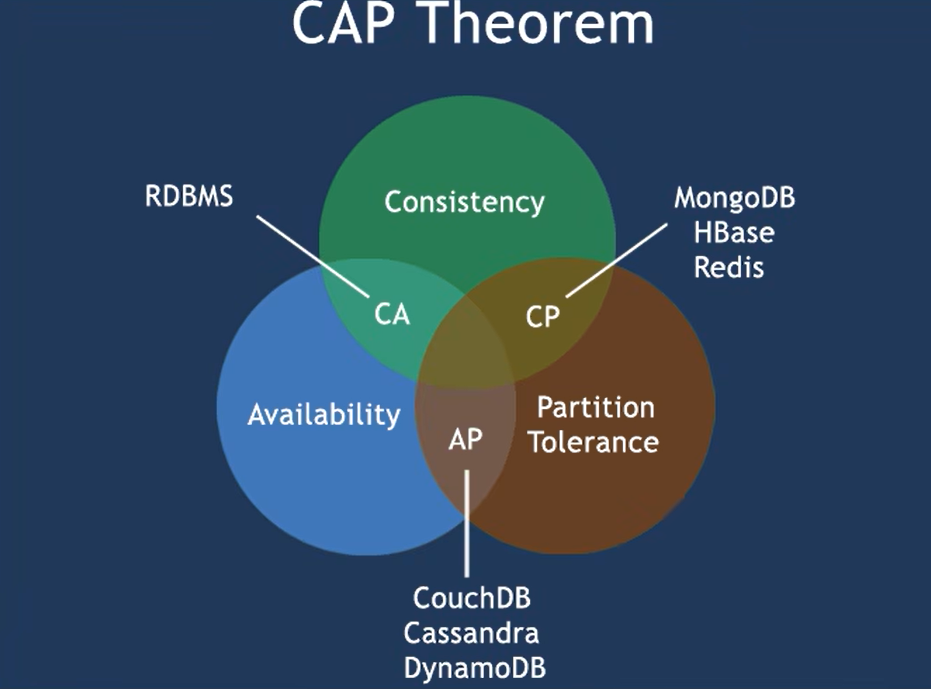

三个注册中心异同点

| 组件名 | 语言 | CAP | 服务健康检查 | 对外暴露接口 | Spring Cloud集成 |

|---|---|---|---|---|---|

| Eureka | Java | AP | 可配支持 | HTTP | 已集成 |

| Consul | Go | CP | 支持 | HTTP/DNS | 已集成 |

| Zookeeper | Java | CP | 支持 | 客户端 | 已集成 |

CAP:

- C:Consistency (强一致性)

- A:Availability (可用性)

- P:Partition tolerance (分区容错性)

CAP理论关注粒度是数据,而不是整体系统设计的策略

最多只能同时较好的满足两个。

CAP理论的核心是:一个分布式系统不可能同时很好的满足一致性,可用性和分区容错性这三个需求。

因此,根据CAP原理将NoSQL数据库分成了满足CA原则、满足CP原则和满足AP原则三大类:

- CA - 单点集群,满足—致性,可用性的系统,通常在可扩展性上不太强大。

- CP - 满足一致性,分区容忍必的系统,通常性能不是特别高。

- AP - 满足可用性,分区容忍性的系统,通常可能对一致性要求低一些。

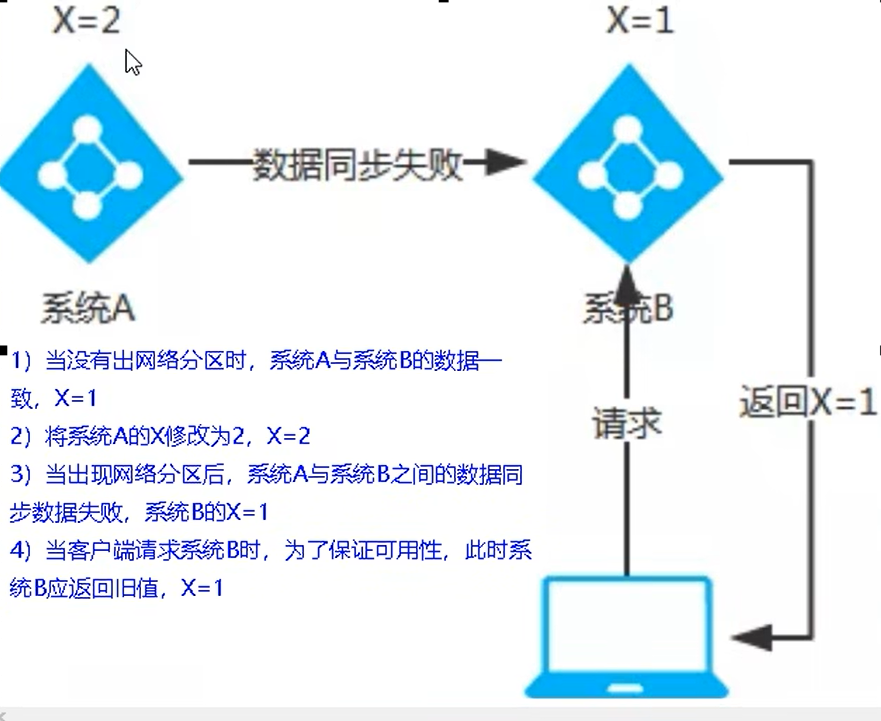

AP架构(Eureka)

当网络分区出现后,为了保证可用性,系统B可以返回旧值,保证系统的可用性。

结论:违背了一致性C的要求,只满足可用性和分区容错,即AP

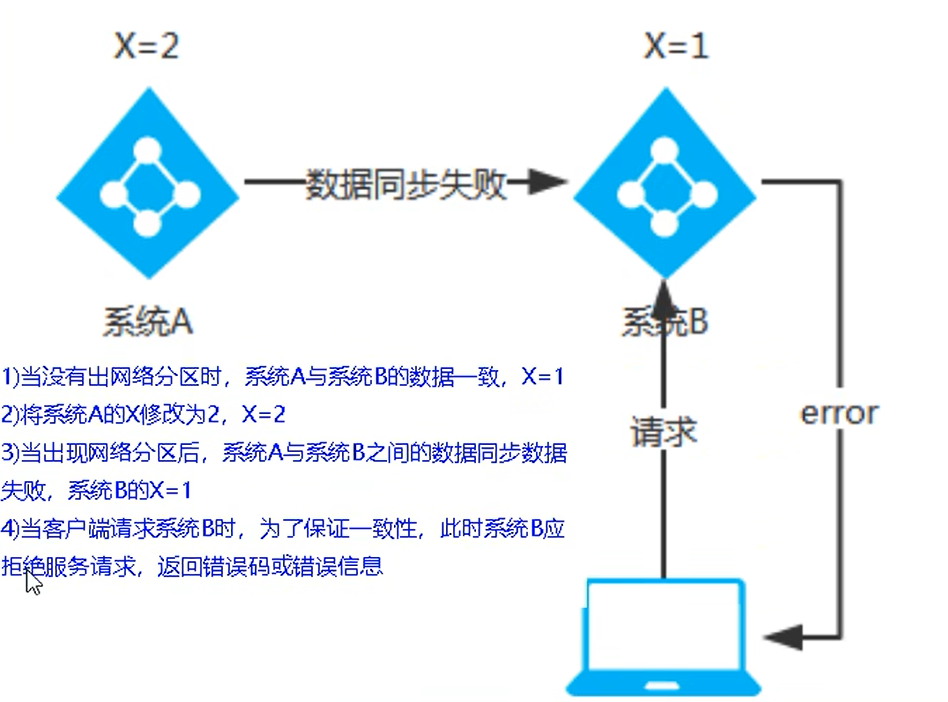

CP架构(ZooKeeper/Consul)

当网络分区出现后,为了保证一致性,就必须拒接请求,否则无法保证一致性。

结论:违背了可用性A的要求,只满足一致性和分区容错,即CP。

CP 与 AP 对立同一的矛盾关系。

服务调用

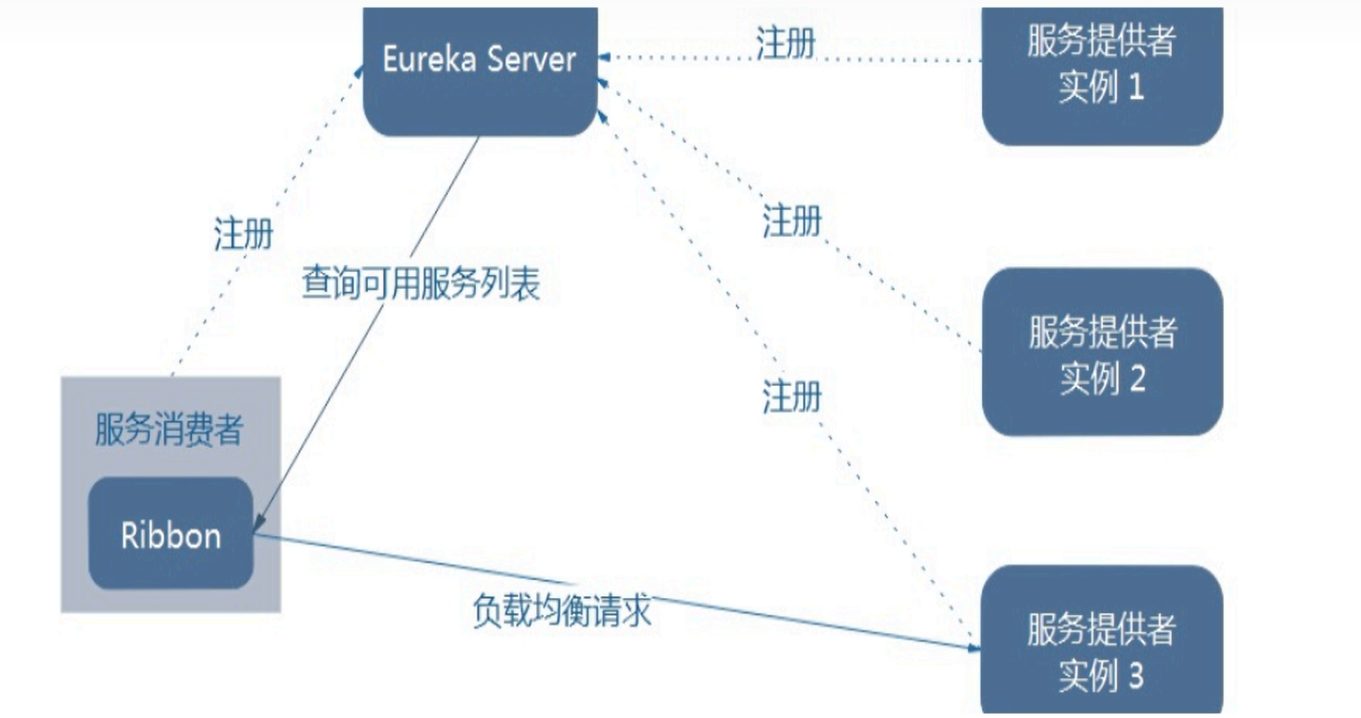

Ribben负载均衡

Spring Cloud Ribbon是基于Netflix Ribbon实现的一套客户端 负载均衡的工具。

简单的说,Ribbon是Netflix发布的开源项目,主要功能是提供客户端的软件负载均衡算法和服务调用。Ribbon客户端组件提供一系列完善的配置项如连接超时,重试等。

简单的说,就是在配置文件中列出Load Balancer(简称LB)后面所有的机器,Ribbon会自动的帮助你基于某种规则(如简单轮询,随机连接等)去连接这些机器。我们很容易使用Ribbon实现自定义的负载均衡算法。

ribbon

英 [ˈrɪbən] 美 [ˈrɪbən]

n. (用于捆绑或装饰的)带子;丝带;带状物;狭长的东西;绶带;勋带

Ribbon目前也进入维护模式。

Ribbon未来可能被Spring Cloud LoadBalacer替代。

LB负载均衡(Load Balance)是什么

简单的说就是将用户的请求平摊的分配到多个服务上,从而达到系统的HA (高可用)。

常见的负载均衡有软件Nginx,LVS,硬件F5等。

Ribbon本地负载均衡客户端 VS Nginx服务端负载均衡区别

Nginx是服务器负载均衡,客户端所有请求都会交给nginx,然后由nginx实现转发请求。即负载均衡是由服务端实现的。

Ribbon本地负载均衡,在调用微服务接口时候,会在注册中心上获取注册信息服务列表之后缓存到 JVM本地,从而在本地实现RPC远程服务调用技术。

集中式LB

即在服务的消费方和提供方之间使用独立的LB设施(可以是硬件,如F5, 也可以是软件,如nginx),由该设施负责把访问请求通过某种策略转发至服务的提供方;

进程内LB

将LB逻辑集成到消费方,消费方从服务注册中心获知有哪些地址可用,然后自己再从这些地址中选择出一个合适的服务器。

Ribbon就属于进程内LB,它只是一个类库,集成于消费方进程,消费方通过它来获取到服务提供方的地址。

一句话 负载均衡 + RestTemplate调用Ribbon的负载均衡和Rest调用

总结:Ribbon其实就是一个软负载均衡的客户端组件,它可以和其他所需请求的客户端结合使用,和Eureka结合只是其中的一个实例。

Ribbon在工作时分成两步:

- 第一步先选择EurekaServer ,它优先选择在同一个区域内负载较少的server。

- 第二步再根据用户指定的策略,在从server取到的服务注册列表中选择一个地址。

其中Ribbon提供了多种策略:比如轮询、随机和根据响应时间加权。

使用Ribbon:

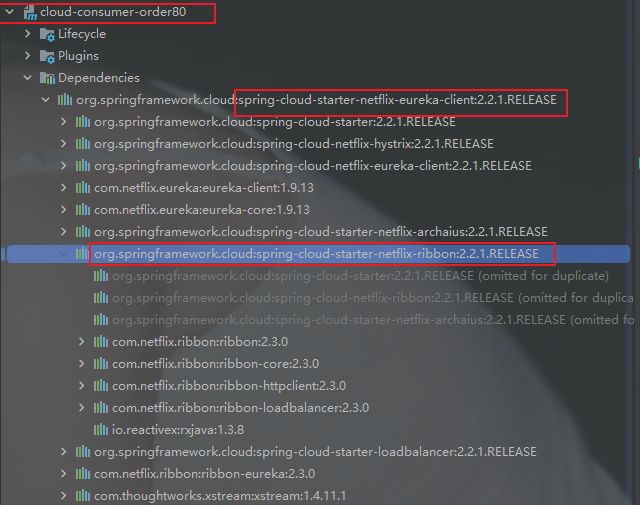

1,默认我们使用eureka的新版本时,它默认集成了ribbon:

这是因为spring-cloud-starter-netflix-eureka-client自带了spring-cloud-starter-ribbon引用。

2,我们也可以手动引入ribbon

放到order模块中,因为只有order访问pay时需要负载均衡

先前工程项目没有引入spring-cloud-starter-ribbon也可以使用ribbon。

<dependency>

<groupld>org.springframework.cloud</groupld>

<artifactld>spring-cloud-starter-netflix-ribbon</artifactid>

</dependency>RestTemplate的使用

getForObject() / getForEntity() - GET请求方法

getForObject():返回对象为响应体中数据转化成的对象,基本上可以理解为Json。

getForEntity():返回对象为ResponseEntity对象,包含了响应中的一些重要信息,比如响应头、响应状态码、响应体等。

@GetMapping("/payment/getForEntity/{id}")

public CommonResult<Payment> getPayment2(@PathVariable("id") Long id)

{

ResponseEntity<CommonResult> entity = restTemplate.getForEntity(PAYMENT_URL+"/payment/get/"+id,CommonResult.class);

if(entity.getStatusCode().is2xxSuccessful()){

return entity.getBody();//getForObject()

}else{

return new CommonResult<>(444,"操作失败");

}

}postForObject() / postForEntity() - POST请求方法

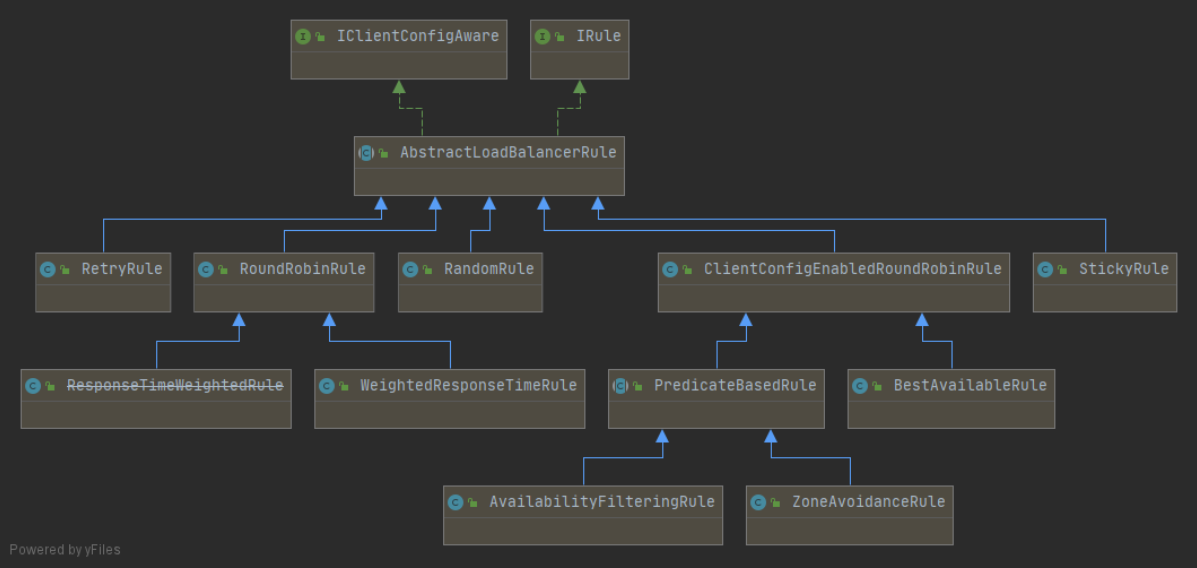

Ribbon默认自带的负载规则

lRule:根据特定算法中从服务列表中选取一个要访问的服务

- com.netflix.loadbalancer.RoundRobinRule 轮询

- com.netflix.loadbalancer.RandomRule 随机

- com.netflix.loadbalancer.RetryRule 先按照RoundRobinRule的策略获取服务,如果获取服务失败则在指定时间内会进行重

- WeightedResponseTimeRule 对RoundRobinRule的扩展,响应速度越快的实例选择权重越大,越容易被选择

- BestAvailableRule 会先过滤掉由于多次访问故障而处于断路器跳闸状态的服务,然后选择一个并发量最小的服务

- AvailabilityFilteringRule 先过滤掉故障实例,再选择并发较小的实例

- ZoneAvoidanceRule 默认规则,复合判断server所在区域的性能和server的可用性选择服务器

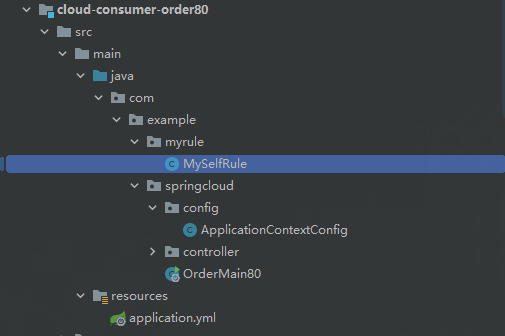

Ribbon负载规则替换

1.修改cloud-consumer-order80

2.注意配置细节

官方文档明确给出了警告:

这个自定义配置类不能放在@ComponentScan所扫描的当前包下以及子包下,

否则我们自定义的这个配置类就会被所有的Ribbon客户端所共享,达不到特殊化定制的目的了。(也就是说不要将Ribbon配置类与主启动类同包)

3.新建package - myrule

4.在com.example.myrule下新建MySelfRule规则类

import com.netflix.loadbalancer.IRule;

import com.netflix.loadbalancer.RandomRule;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

@Configuration

public class MySelfRule {

@Bean

public IRule myRule(){

return new RandomRule();

}

}

5.主启动类添加@RibbonClient

表示,访问CLOUD_PAYMENT_SERVICE的服务时,使用我们自定义的负载均衡算法

import com.example.myrule.MySelfRule;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.EnableEurekaClient;

import org.springframework.cloud.netflix.ribbon.RibbonClient;

@SpringBootApplication

@EnableEurekaClient

@RibbonClient(name = "CLOUD-PAYMENT-SERVICE",configuration = MySelfRule.class)

public class OrderMain80 {

public static void main(String[] args) {

SpringApplication.run(OrderMain80.class,args);

}

}6.测试

开启cloud-eureka-server7001,cloud-consumer-order80,cloud-provider-payment8001,cloud-provider-payment8002

浏览器-输入http://localhost/consumer/payment/get/31

返回结果中的serverPort在8001与8002两种间反复横跳。

Ribbon默认负载轮询算法原理

默认负载轮训算法: rest接口第几次请求数 % 服务器集群总数量 = 实际调用服务器位置下标,每次服务重启动后rest接口计数从1开始。

List

如:

- List [0] instances = 127.0.0.1:8002

- List [1] instances = 127.0.0.1:8001

8001+ 8002组合成为集群,它们共计2台机器,集群总数为2,按照轮询算法原理:

- 当总请求数为1时:1%2=1对应下标位置为1,则获得服务地址为127.0.0.1:8001

- 当总请求数位2时:2%2=0对应下标位置为0,则获得服务地址为127.0.0.1:8002

- 当总请求数位3时:3%2=1对应下标位置为1,则获得服务地址为127.0.0.1:8001

- 当总请求数位4时:4%2=0对应下标位置为0,则获得服务地址为127.0.0.1:8002

- 如此类推…

RoundRobinRule源码分析

public interface IRule{

/*

* choose one alive server from lb.allServers or

* lb.upServers according to key

*

* @return choosen Server object. NULL is returned if none

* server is available

*/

//重点关注这方法

public Server choose(Object key);

public void setLoadBalancer(ILoadBalancer lb);

public ILoadBalancer getLoadBalancer();

}package com.netflix.loadbalancer;

import com.netflix.client.config.IClientConfig;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import java.util.List;

import java.util.concurrent.atomic.AtomicInteger;

/**

* The most well known and basic load balancing strategy, i.e. Round Robin Rule.

*

* @author stonse

* @author Nikos Michalakis <nikos@netflix.com>

*

*/

public class RoundRobinRule extends AbstractLoadBalancerRule {

private AtomicInteger nextServerCyclicCounter;

private static final boolean AVAILABLE_ONLY_SERVERS = true;

private static final boolean ALL_SERVERS = false;

private static Logger log = LoggerFactory.getLogger(RoundRobinRule.class);

public RoundRobinRule() {

nextServerCyclicCounter = new AtomicInteger(0);

}

public RoundRobinRule(ILoadBalancer lb) {

this();

setLoadBalancer(lb);

}

//重点关注这方法。

public Server choose(ILoadBalancer lb, Object key) {

if (lb == null) {

log.warn("no load balancer");

return null;

}

Server server = null;

int count = 0;

while (server == null && count++ < 10) {

List<Server> reachableServers = lb.getReachableServers();

List<Server> allServers = lb.getAllServers();

int upCount = reachableServers.size();

int serverCount = allServers.size();

if ((upCount == 0) || (serverCount == 0)) {

log.warn("No up servers available from load balancer: " + lb);

return null;

}

int nextServerIndex = incrementAndGetModulo(serverCount);

server = allServers.get(nextServerIndex);

if (server == null) {

/* Transient. */

Thread.yield();

continue;

}

if (server.isAlive() && (server.isReadyToServe())) {

return (server);

}

// Next.

server = null;

}

if (count >= 10) {

log.warn("No available alive servers after 10 tries from load balancer: "

+ lb);

}

return server;

}

/**

* Inspired by the implementation of {@link AtomicInteger#incrementAndGet()}.

*

* @param modulo The modulo to bound the value of the counter.

* @return The next value.

*/

private int incrementAndGetModulo(int modulo) {

for (;;) {

int current = nextServerCyclicCounter.get();

int next = (current + 1) % modulo;//求余法

if (nextServerCyclicCounter.compareAndSet(current, next))

return next;

}

}

@Override

public Server choose(Object key) {

return choose(getLoadBalancer(), key);

}

@Override

public void initWithNiwsConfig(IClientConfig clientConfig) {

}

}Ribbon之手写轮询算法

自己试着写一个类似RoundRobinRule的本地负载均衡器。

- 7001/7002集群启动

- 8001/8002微服务改造- controller

@RestController

@Slf4j

public class PaymentController{

...

@GetMapping(value = "/payment/lb")

public String getPaymentLB() {

//返回服务接口

return serverPort;

}

...

}- 80订单微服务改造

1.ApplicationContextConfig去掉注解@LoadBalanced,OrderMain80去掉注解@RibbonClient

import org.springframework.cloud.client.loadbalancer.LoadBalanced;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.web.client.RestTemplate;

@Configuration

public class ApplicationContextConfig {

@Bean

//@LoadBalanced

public RestTemplate getRestTemplate(){

return new RestTemplate();

}

}2.创建LoadBalancer接口

import org.springframework.cloud.client.ServiceInstance;

import java.util.List;

public interface LoadBalancer{

ServiceInstance instances(List<ServiceInstance> serviceInstances);

}3.MyLB

实现LoadBalancer接口

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.stereotype.Component;

import java.util.List;

import java.util.concurrent.atomic.AtomicInteger;

/**

*/

@Component//需要跟主启动类同包,或者在其子孙包下。

public class MyLB implements LoadBalancer

{

private AtomicInteger atomicInteger = new AtomicInteger(0);

public final int getAndIncrement()

{

int current;

int next;

do {

current = this.atomicInteger.get();

next = current >= 2147483647 ? 0 : current + 1;

}while(!this.atomicInteger.compareAndSet(current,next));

log.info("*****第几次访问,次数:next: "+next);

return next;

}

//负载均衡算法:rest接口第几次请求数 % 服务器集群总数量 = 实际调用服务器位置下标 ,每次服务重启动后rest接口计数从1开始。

@Override

public ServiceInstance instances(List<ServiceInstance> serviceInstances)

{

int index = getAndIncrement() % serviceInstances.size();

return serviceInstances.get(index);

}

}4.OrderController

import org.springframework.cloud.client.ServiceInstance;

import org.springframework.cloud.client.discovery.DiscoveryClient;

import com.lun.springcloud.lb.LoadBalancer;

@Slf4j

@RestController

public class OrderController {

//public static final String PAYMENT_URL = "http://localhost:8001";

public static final String PAYMENT_URL = "http://CLOUD-PAYMENT-SERVICE";

...

@Resource

private LoadBalancer loadBalancer;

@Resource

private DiscoveryClient discoveryClient;

...

@GetMapping(value = "/consumer/payment/lb")

public String getPaymentLB()

{

List<ServiceInstance> instances = discoveryClient.getInstances("CLOUD-PAYMENT-SERVICE");

if(instances == null || instances.size() <= 0){

return null;

}

ServiceInstance serviceInstance = loadBalancer.instances(instances);

URI uri = serviceInstance.getUri();

return restTemplate.getForObject(uri+"/payment/lb",String.class);

}

}5.测试 不停地刷新http://localhost/consumer/payment/lb,可以看到8001/8002交替出现。

OpenFeign

基本概念

Feign能干什么Feign is a declarative web service client. It makes writing web service clients easier. To use Feign create an interface and annotate it. It has pluggable annotation support including Feign annotations and JAX-RS annotations. Feign also supports pluggable encoders and decoders. Spring Cloud adds support for Spring MVC annotations and for using the same HttpMessageConverters used by default in Spring Web. Spring Cloud integrates Ribbon and Eureka, as well as Spring Cloud LoadBalancer to provide a load-balanced http client when using Feign. link

Feign是一个声明式WebService客户端。使用Feign能让编写Web Service客户端更加简单。它的使用方法是定义一个服务接口然后在上面添加注解。Feign也支持可拔插式的编码器和解码器。Spring Cloud对Feign进行了封装,使其支持了Spring MVC标准注解和HttpMessageConverters。Feign可以与Eureka和Ribbon组合使用以支持负载均衡。

Feign旨在使编写Java Http客户端变得更容易。

前面在使用Ribbon + RestTemplate时,利用RestTemplate对http请求的封装处理,形成了一套模版化的调用方法。但是在实际开发中,由于对服务依赖的调用可能不止一处,往往一个接口会被多处调用,所以通常都会针对每个微服务自行封装一些客户端类来包装这些依赖服务的调用。所以,Feign在此基础上做了进一步封装,由他来帮助我们定义和实现依赖服务接口的定义。在Feign的实现下,我们只需创建一个接口并使用注解的方式来配置它(以前是Dao接口上面标注Mapper注解,现在是一个微服务接口上面标注一个Feign注解即可),即可完成对服务提供方的接口绑定,简化了使用Spring cloud Ribbon时,自动封装服务调用客户端的开发量。

Feign集成了Ribbon利用Ribbon维护了Payment的服务列表信息,并且通过轮询实现了客户端的负载均衡。而与Ribbon不同的是,通过feign只需要定义服务绑定接口且以声明式的方法,优雅而简单的实现了服务调用。

Feign和OpenFeign两者区别| Feign | OpenFeign |

|---|---|

| Feign是Spring Cloud组件中的一个轻量级RESTful的HTTP服务客户端Feign内置了Ribbon,用来做客户端负载均衡,去调用服务注册中心的服务。Feign的使用方式是:使用Feign的注解定义接口,调用这个接口,就可以调用服务注册中心的服务。 | OpenFeign是Spring Cloud在Feign的基础上支持了SpringMVC的注解,如@RequesMapping等等。OpenFeign的@Feignclient可以解析SpringMVc的@RequestMapping注解下的接口,并通过动态代理的方式产生实现类,实现类中做负载均衡并调用其他服务。 |

feign

英 [feɪn] 美 [feɪn]

v. 假装,装作,佯装(有某种感觉或生病、疲倦等)

OpenFeign服务调用

接口+注解:微服务调用接口 + @FeignClient

1.新建模块

名字:cloud-consumer-feign-order80

2.POM

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<artifactId>LearnCloud</artifactId>

<groupId>com.lun.springcloud</groupId>

<version>1.0.0-SNAPSHOT</version>

</parent>

<modelVersion>4.0.0</modelVersion>

<artifactId>cloud-consumer-feign-order80</artifactId>

<dependencies>

<!--openfeign-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-openfeign</artifactId>

</dependency>

<!--eureka client-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

<!-- 引入自己定义的api通用包,可以使用Payment支付Entity -->

<dependency>

<groupId>org.example</groupId>

<artifactId>cloud-api-commons</artifactId>

<version>${project.version}</version>

</dependency>

<!--web-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<!--一般基础通用配置-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

</project>3.YML

server:

port: 80

eureka:

client:

register-with-eureka: false

service-url:

defaultZone: http://eureka7001.com:7001/eureka/,http://eureka7002.com:7002/eureka/4.主启动

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.openfeign.EnableFeignClients;

@SpringBootApplication

@EnableFeignClients

public class OrderFeignMain80 {

public static void main(String[] args) {

SpringApplication.run(OrderFeignMain80.class, args);

}

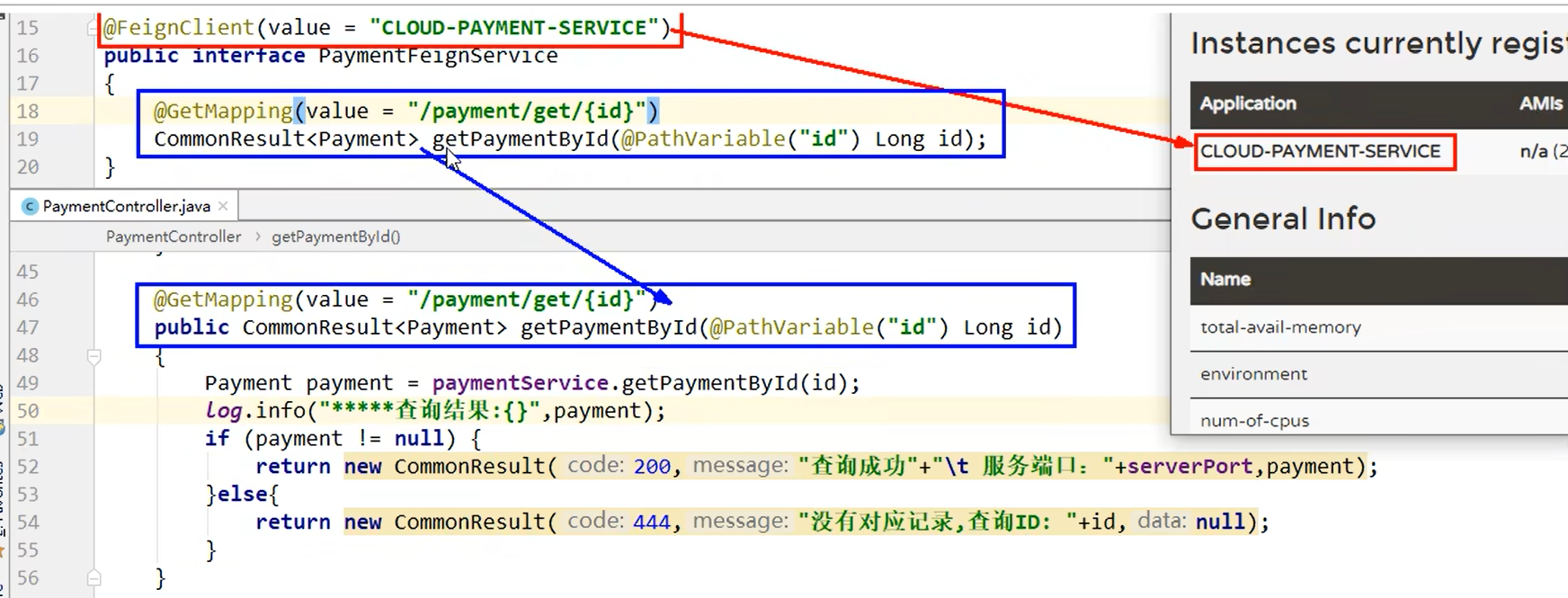

}5.业务类

业务逻辑接口+@FeignClient配置调用provider服务

新建PaymentFeignService接口并新增注解@FeignClient

import com.lun.springcloud.entities.CommonResult;

import com.lun.springcloud.entities.Payment;

import org.springframework.cloud.openfeign.FeignClient;

import org.springframework.stereotype.Component;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

@Component

@FeignClient(value = "CLOUD-PAYMENT-SERVICE")

public interface PaymentFeignService

{

@GetMapping(value = "/payment/get/{id}")

public CommonResult<Payment> getPaymentById(@PathVariable("id") Long id);

}控制层Controller

import com.example.springcloud.pojo.CommonResult;

import com.example.springcloud.pojo.Payment;

import com.example.springcloud.service.PaymentFeignService;

import lombok.extern.slf4j.Slf4j;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import javax.annotation.Resource;

@Slf4j

@RestController

@RequestMapping("/consumer")

public class OrderFeignController {

@Resource

private PaymentFeignService paymentFeignService;

/**

* 通过id查订单

* @param id 订单id

* @return 订单

*/

@GetMapping("/payment/get/{id}")

public CommonResult<Payment> getPaymentById(@PathVariable("id") Long id){

return paymentFeignService.getPaymentById(id);

}

}6.测试

先启动2个eureka集群7001/7002

再启动2个微服务8001/8002

启动OpenFeign启动

http://localhost/consumer/payment/get/1

Feign自带负载均衡配置项

OpenFeign超时控制

超时设置,故意设置超时演示出错情况

1.服务提供方8001/8002故意写暂停程序

@RestController

@Slf4j

@RequestMapping("/payment")

public class PaymentController {

...

@Value("${server.port}")

private String serverPort;

...

@GetMapping(value = "/feign/timeout")

public String paymentFeignTimeout()

{

// 业务逻辑处理正确,但是需要耗费3秒钟

try {

TimeUnit.SECONDS.sleep(3);

} catch (InterruptedException e) {

e.printStackTrace();

}

return serverPort;

}

...

}2.服务消费方80添加超时方法PaymentFeignService

@Component

@FeignClient(value = "CLOUD-PAYMENT-SERVICE")

public interface PaymentFeignService{

...

@GetMapping(value = "/payment/feign/timeout")

public String paymentFeignTimeout();

}3.服务消费方80添加超时方法OrderFeignController

@RestController

@Slf4j

@RequestMapping("/consumer")

public class OrderFeignController

{

@Resource

private PaymentFeignService paymentFeignService;

...

@GetMapping(value = "/payment/feign/timeout")

public String paymentFeignTimeout()

{

// OpenFeign客户端一般默认等待1秒钟

return paymentFeignService.paymentFeignTimeout();

}

}4.测试:

多次刷新 http://localhost/consumer/payment/feign/timeout

将会跳出错误Spring Boot默认错误页面,主要异常:feign.RetryableException:Read timed out executing GET http://CLOUD-PAYMENT-SERVCE/payment/feign/timeout。

OpenFeign默认等待1秒钟,超过后报错

YML文件里需要开启OpenFeign客户端超时控制

#设置feign客户端超时时间(OpenFeign默认支持ribbon)(单位:毫秒)

ribbon:

#指的是建立连接所用的时间,适用于网络状况正常的情况下,两端连接所用的时间

ReadTimeout: 5000

#指的是建立连接后从服务器读取到可用资源所用的时间

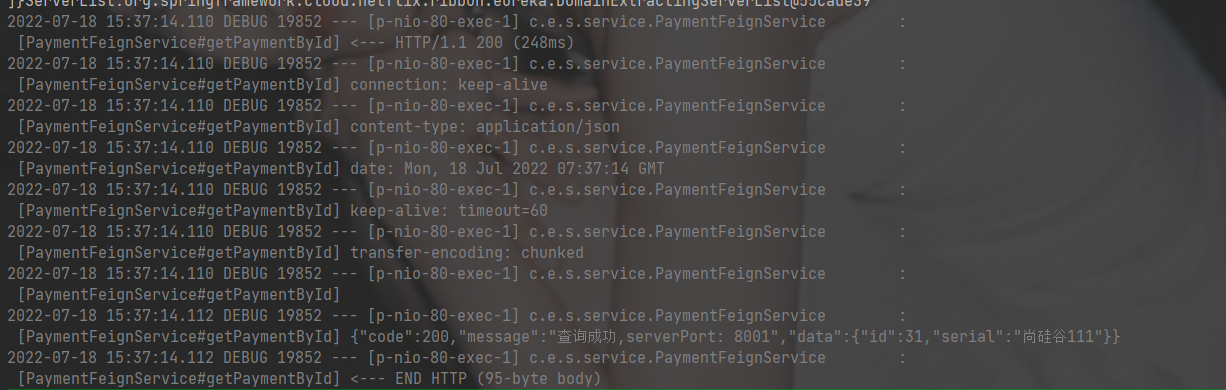

ConnectTimeout: 5000OpenFeign日志增强

日志打印功能

Feign提供了日志打印功能,我们可以通过配置来调整日恙级别,从而了解Feign 中 Http请求的细节。

说白了就是对Feign接口的调用情况进行监控和输出

日志级别

- NONE:默认的,不显示任何日志;

- BASIC:仅记录请求方法、URL、响应状态码及执行时间;

- HEADERS:除了BASIC中定义的信息之外,还有请求和响应的头信息;

- FULL:除了HEADERS中定义的信息之外,还有请求和响应的正文及元数据。

配置日志bean

import feign.Logger;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

@Configuration

public class FeignConfig{

@Bean

Logger.Level feignLoggerLevel()

{

return Logger.Level.FULL;

}

}YML文件里需要开启日志的Feign客户端

logging:

level:

# feign日志以什么级别监控哪个接口

com.example.springcloud.service.PaymentFeignService: debug后台日志查看

得到更多日志信息。

服务降级

Hystrix

概述

分布式系统面临的问题

复杂分布式体系结构中的应用程序有数十个依赖关系,每个依赖关系在某些时候将不可避免地失败。

服务雪崩

多个微服务之间调用的时候,假设微服务A调用微服务B和微服务C,微服务B和微服务C又调用其它的微服务,这就是所谓的“扇出”。如果扇出的链路上某个微服务的调用响应时间过长或者不可用,对微服务A的调用就会占用越来越多的系统资源,进而引起系统崩溃,所谓的“雪崩效应”.

对于高流量的应用来说,单一的后避依赖可能会导致所有服务器上的所有资源都在几秒钟内饱和。比失败更糟糕的是,这些应用程序还可能导致服务之间的延迟增加,备份队列,线程和其他系统资源紧张,导致整个系统发生更多的级联故障。这些都表示需要对故障和延迟进行隔离和管理,以便单个依赖关系的失败,不能取消整个应用程序或系统。

所以,通常当你发现一个模块下的某个实例失败后,这时候这个模块依然还会接收流量,然后这个有问题的模块还调用了其他的模块,这样就会发生级联故障,或者叫雪崩。

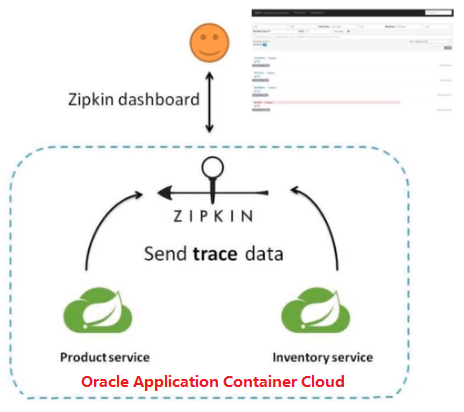

Hystrix是什么

Hystrix是一个用于处理分布式系统的延迟和容错的开源库,在分布式系统里,许多依赖不可避免的会调用失败,比如超时、异常等,Hystrix能够保证在一个依赖出问题的情况下,不会导致整体服务失败,避免级联故障,以提高分布式系统的弹性。

“断路器”本身是一种开关装置,当某个服务单元发生故障之后,通过断路器的故障监控(类似熔断保险丝),向调用方返回一个符合预期的、可处理的备选响应(FallBack),而不是长时间的等待或者抛出调用方无法处理的异常,这样就保证了服务调用方的线程不会被长时间、不必要地占用,从而避免了故障在分布式系统中的蔓延,乃至雪崩。

hystrix

n. 豪猪属;猬草属;豪猪;豪猪亚属

Hystrix停更进维

能干嘛

- 服务降级

- 服务熔断

- 接近实对的监控

- …

官网资料

Hystrix官宣,停更进维

- 被动修bugs

- 不再接受合并请求

- 不再发布新版本

Hystrix的服务降级熔断限流概念初讲

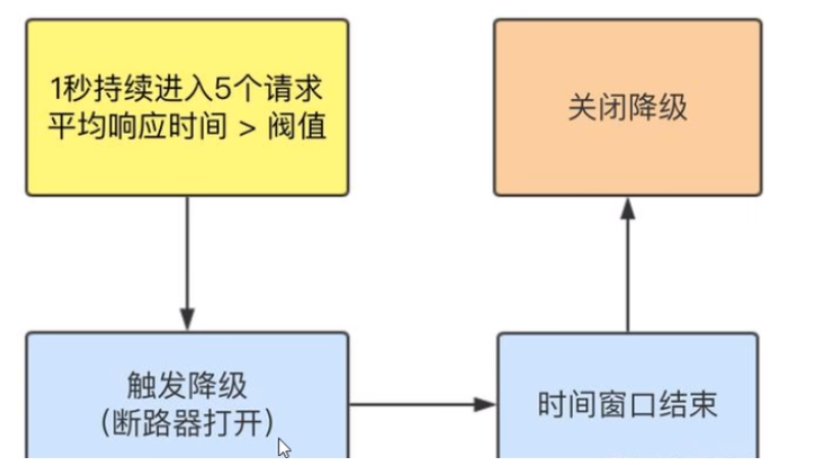

服务降级

服务器忙,请稍后再试,不让客户端等待并立刻返回一个友好提示,fallback

哪些情况会触发降级

- 程序运行导常

- 超时

- 服务熔断触发服务降级

- 线程池/信号量打满也会导致服务降级

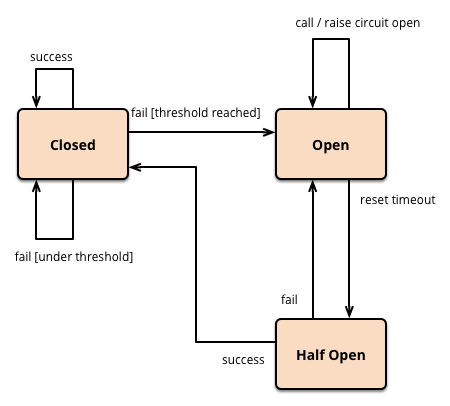

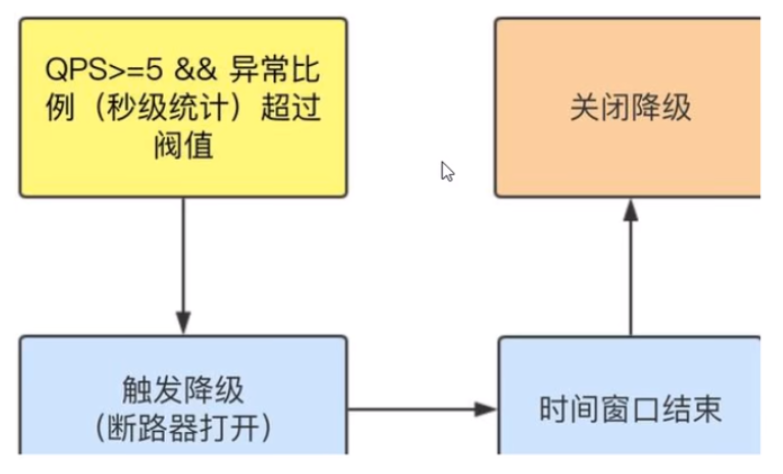

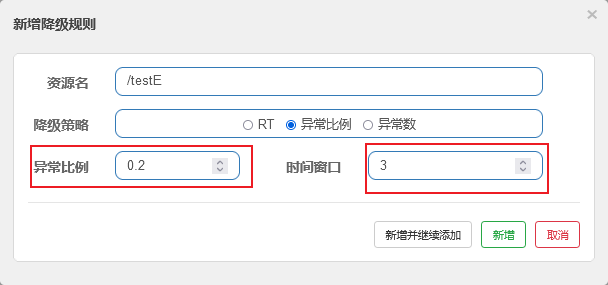

服务熔断

类比保险丝达到最大服务访问后,直接拒绝访问,拉闸限电,然后调用服务降级的方法并返回友好提示。

服务的降级 -> 进而熔断 -> 恢复调用链路

服务限流

秒杀高并发等操作,严禁一窝蜂的过来拥挤,大家排队,一秒钟N个,有序进行。

Hystrix支付微服务构建

订单微服务提供者

将cloud-eureka-server7001改配置成单机版

1.新建模块

名字:cloud-provider-hygtrix-payment8001

2.POM

<dependencies>

<!--hystrix-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-hystrix</artifactId>

</dependency>

<!--eureka client-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

<!--web-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<!-- 引入自己定义的api通用包,可以使用Payment支付Entity -->

<dependency>

<groupId>org.example</groupId>

<artifactId>cloud-api-commons</artifactId>

<version>${project.version}</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>3.YML

server:

port: 8001

spring:

application:

name: cloud-provider-hystrix-payment

eureka:

client:

register-with-eureka: true

fetch-registry: true

service-url:

#defaultZone: http://eureka7001.com:7001/eureka,http://eureka7002.com:7002/eureka

defaultZone: http://eureka7001.com:7001/eureka4.主启动

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.eureka.EnableEurekaClient;

@SpringBootApplication

@EnableEurekaClient

public class PaymentHystrixMain8001{

public static void main(String[] args) {

SpringApplication.run(PaymentHystrixMain8001.class, args);

}

}5.业务类

service

import org.springframework.stereotype.Service;

import java.util.concurrent.TimeUnit;

@Service

public class PaymentService {

/**

* 正常访问 ok

* @param id id

* @return 字符串

*/

public String paymentInfo_OK(Integer id) {

return "线程池: "+Thread.currentThread().getName()+" paymentInfo_OK,id: "+id+"\t"+"O(∩_∩)O哈哈~";

}

/**

* 超时访问 error

* @param id id

* @return 字符串

*/

public String paymentInfo_TimeOut(Integer id) {

try { TimeUnit.MILLISECONDS.sleep(3000); } catch (InterruptedException e) { e.printStackTrace(); }

return "线程池: "+Thread.currentThread().getName()+" id: "+id+"\t"+"O(∩_∩)O哈哈~"+" 耗时(秒): 3";

}

}controller

import com.lun.springcloud.service.PaymentService;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RestController;

import javax.annotation.Resource;

@Slf4j

@RestController

@RequestMapping("/payment")

public class PaymentController {

@Resource

private PaymentService paymentService;

@Value("${server.port}")

private String serverPort;

@GetMapping("/hystrix/ok/{id}")

public String paymentInfo_OK(@PathVariable("id") Integer id) {

String result = paymentService.paymentInfo_OK(id);

log.info("*****result: "+result);

return result;

}

@GetMapping("/hystrix/timeout/{id}")

public String paymentInfo_TimeOut(@PathVariable("id") Integer id) {

String result = paymentService.paymentInfo_TimeOut(id);

log.info("*****result: "+result);

return result;

}

}6.正常测试

启动eureka7001

启动cloud-provider-hystrix-payment8001

访问

success的方法 - http://localhost:8001/payment/hystrix/ok/1

每次调用耗费5秒钟 - http://localhost:8001/payment/hystrix/timeout/1

上述module均OK

以上述为根基平台,从正确 -> 错误 -> 降级熔断 -> 恢复。

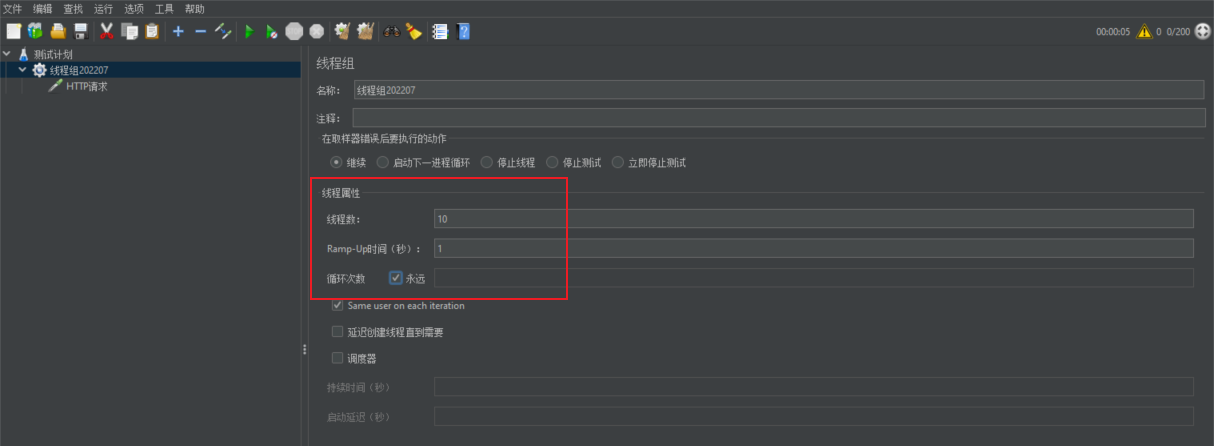

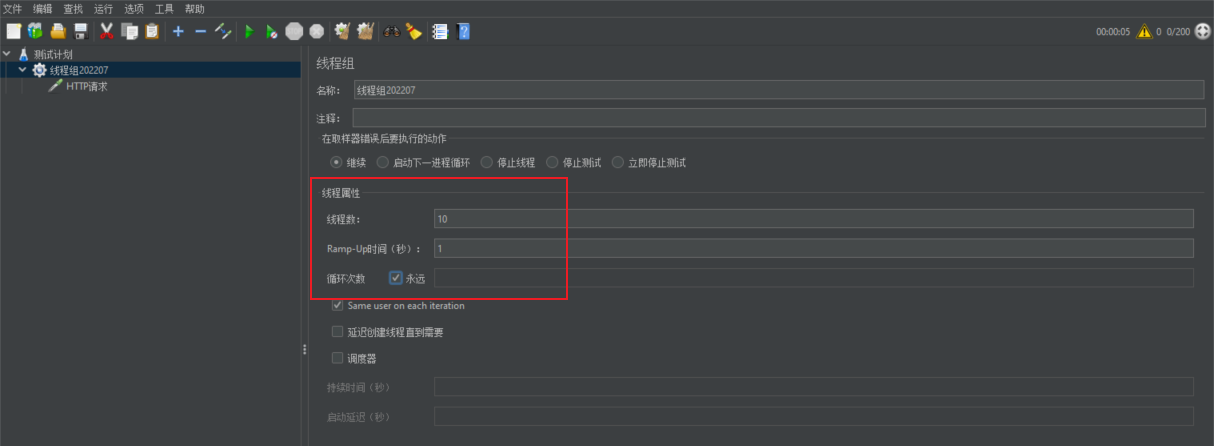

7.JMeter高并发压测后卡顿

上述在非高并发情形下,还能勉强满足

Jmeter压测测试

The Apache JMeter™ application is open source software, a 100% pure Java application designed to load test functional behavior and measure performance. It was originally designed for testing Web Applications but has since expanded to other test functions.

开启Jmeter,来20000个并发压死8001,20000个请求都去访问paymentInfo_TimeOut服务

1.测试计划中右键添加-> 线程-> 线程组(线程组202102,线程数:200,线程数:100,其他参数默认)

2.刚刚新建线程组202102,右键它-》添加-》取样器-》Http请求-》基本 输入http://localhost:8001/payment/hystrix/ok/1

3.点击绿色三角形图标启动。

看演示结果:拖慢,原因:tomcat的默认的工作线程数被打满了,没有多余的线程来分解压力和处理。

Jmeter压测结论

上面还是服务提供者8001自己测试,假如此时外部的消费者80也来访问,那消费者只能干等,最终导致消费端80不满意,服务端8001直接被拖慢。

订单微服务调用支付服务出现卡顿

看热闹不嫌弃事大,80新建加入

1.新建模块

名字:cloud-consumer-feign-hystrix-order80

2.POM

<dependencies>

<!--openfeign-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-openfeign</artifactId>

</dependency>

<!--hystrix-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-hystrix</artifactId>

</dependency>

<!--eureka client-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

<!-- 引入自己定义的api通用包,可以使用Payment支付Entity -->

<dependency>

<groupId>org.example</groupId>

<artifactId>cloud-api-commons</artifactId>

<version>${project.version}</version>

</dependency>

<!--web-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

<!--一般基础通用配置-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>3,YML

server:

port: 80

eureka:

client:

register-with-eureka: false

service-url:

defaultZone: http://eureka7001.com:7001/eureka/4,主启动

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.hystrix.EnableHystrix;

import org.springframework.cloud.openfeign.EnableFeignClients;

@SpringBootApplication

@EnableFeignClients

//@EnableHystrix

public class OrderHystrixMain80{

public static void main(String[] args){

SpringApplication.run(OrderHystrixMain80.class,args);

}

}5.业务类

import org.springframework.cloud.openfeign.FeignClient;

import org.springframework.stereotype.Component;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

@Component

@FeignClient(value = "CLOUD-PROVIDER-HYSTRIX-PAYMENT" /*,fallback = PaymentFallbackService.class*/)

public interface PaymentHystrixService{

@GetMapping("/payment/hystrix/ok/{id}")

String paymentInfo_OK(@PathVariable("id") Integer id);

@GetMapping("/payment/hystrix/timeout/{id}")

String paymentInfo_TimeOut(@PathVariable("id") Integer id);

}controller

import com.lun.springcloud.service.PaymentHystrixService;

import lombok.extern.slf4j.Slf4j;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RestController;

import javax.annotation.Resource;

@Slf4j

@RestController

@RequestMapping("/consumer")

public class OrderHystirxController {

@Resource

private PaymentHystrixService paymentHystrixService;

@GetMapping("/payment/hystrix/ok/{id}")

public String paymentInfo_OK(@PathVariable("id") Integer id) {

return paymentHystrixService.paymentInfo_OK(id);

}

@GetMapping("/payment/hystrix/timeout/{id}")

public String paymentInfo_TimeOut(@PathVariable("id") Integer id) {

return paymentHystrixService.paymentInfo_TimeOut(id);

}

}6.正常测试

http://localhost/consumer/payment/hystrix/ok/1

7.高并发测试

2W个线程压8001

消费端80微服务再去访问正常的Ok微服务8001地址

http://localhost/consumer/payment/hystrix/ok/32

消费者80被拖慢

原因:8001同一层次的其它接口服务被困死,因为tomcat线程池里面的工作线程已经被挤占完毕。

正因为有上述故障或不佳表现才有我们的降级/容错/限流等技术诞生。

Hystrix,服务降级

超时导致服务器变慢(转圈) - 超时不再等待

出错(宕机或程序运行出错) - 出错要有兜底

解决:

- 对方服务(8001)超时了,调用者(80)不能一直卡死等待,必须有服务降级。

- 对方服务(8001)down机了,调用者(80)不能一直卡死等待,必须有服务降级。

- 对方服务(8001)OK,调用者(80)自己出故障或有自我要求(自己的等待时间小于服务提供者),自己处理降级。

服务降级支付测fallback(8001)

降级配置 - @HystrixCommand

8001先从自身找问题

设置自身调用超时时间的峰值,峰值内可以正常运行,超过了需要有兜底的方法处埋,作服务降级fallback。

8001fallback

业务类启用 - @HystrixCommand报异常后如何处理

—旦调用服务方法失败并抛出了错误信息后,会自动调用@HystrixCommand标注好的fallbackMethod调用类中的指定方法

@Service

public class PaymentService {

/**

* 超时访问 error

* @param id id

* @return 字符串

*/

@HystrixCommand(fallbackMethod = "paymentInfo_TimeOutHandler",commandProperties = {

@HystrixProperty(name = "execution.isolation.thread.timeoutInMilliseconds",value = "3000")

})

public String paymentInfo_TimeOut(Integer id) {

//int age = 10/0;

int timeNumber = 5;

try { TimeUnit.SECONDS.sleep(timeNumber); } catch (InterruptedException e) { e.printStackTrace(); }

return "线程池: "+Thread.currentThread().getName()+" id: "+id+"\t"+"O(∩_∩)O哈哈~"+" 耗时(秒): "+timeNumber;

}

/**

* 用来善后的方法

* @param id id

* @return 字符串

*/

public String paymentInfo_TimeOutHandler(Integer id) {

return "线程池: "+Thread.currentThread().getName()+" 8001系统繁忙或者运行报错,请稍后再试,id: "+id+"\t"+"o(╥﹏╥)o";

}

}上面故意制造两种异常:

- int age = 10/0,计算异常

- 我们能接受3秒钟,它运行5秒钟,超时异常。

当前服务不可用了,做服务降级,兜底的方案都是paymentInfo_TimeOutHandler

主启动类激活

添加新注解@EnableCircuitBreaker

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.client.circuitbreaker.EnableCircuitBreaker;

import org.springframework.cloud.netflix.eureka.EnableEurekaClient;

@SpringBootApplication

@EnableEurekaClient

@EnableCircuitBreaker//添加到此处

public class PaymentHystrixMain8001{

public static void main(String[] args) {

SpringApplication.run(PaymentHystrixMain8001.class, args);

}

}服务降级订单测fallback(80)

80订单微服务,也可以更好的保护自己,自己也依样画葫芦进行客户端降级保护

题外话,切记 - 我们自己配置过的热部署方式对java代码的改动明显

但对@HystrixCommand内属性的修改建议重启微服务

YML

server:

port: 80

eureka:

client:

register-with-eureka: false

service-url:

defaultZone: http://eureka7001.com:7001/eureka/

#开启

feign:

hystrix:

enabled: true主启动

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.netflix.hystrix.EnableHystrix;

import org.springframework.cloud.openfeign.EnableFeignClients;

@SpringBootApplication

@EnableFeignClients

@EnableHystrix//添加到此处

public class OrderHystrixMain80{

public static void main(String[] args){

SpringApplication.run(OrderHystrixMain80.class,args);

}

}业务类

import com.example.springcloud.service.PaymentHystrixService;

import com.netflix.hystrix.contrib.javanica.annotation.HystrixCommand;

import com.netflix.hystrix.contrib.javanica.annotation.HystrixProperty;

import lombok.extern.slf4j.Slf4j;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import javax.annotation.Resource;

@Slf4j

@RestController

@RequestMapping("/consumer")

public class OderHystrixController {

@Resource

private PaymentHystrixService paymentHystrixService;

@GetMapping("/payment/hystrix/ok/{id}")

public String paymentInfo_OK(@PathVariable("id") Integer id) {

return paymentHystrixService.paymentInfo_OK(id);

}

@GetMapping("/payment/hystrix/timeout/{id}")

@HystrixCommand(fallbackMethod = "paymentTimeOutFallbackMethod",commandProperties = {

@HystrixProperty(name = "execution.isolation.thread.timeoutInMilliseconds",value = "1500")

})

public String paymentInfo_TimeOut(@PathVariable("id") Integer id) {

return paymentHystrixService.paymentInfo_TimeOut(id);

}

public String paymentTimeOutFallbackMethod(@PathVariable("id") Integer id) {

return "我是消费者80,对方支付系统繁忙请10秒钟后再试或者自己运行出错请检查自己,o(╥﹏╥)o";

}

}全局服务降级DefaultProperties

目前问题1 每个业务方法对应一个兜底的方法,代码膨胀

解决方法

1:1 每个方法配置一个服务降级方法,技术上可以,但是不聪明

1:N 除了个别重要核心业务有专属,其它普通的可以通过@DefaultProperties(defaultFallback = “”)统一跳转到统一处理结果页面

通用的和独享的各自分开,避免了代码膨胀,合理减少了代码量

import com.example.springcloud.service.PaymentHystrixService;

import com.netflix.hystrix.contrib.javanica.annotation.DefaultProperties;

import com.netflix.hystrix.contrib.javanica.annotation.HystrixCommand;

import lombok.extern.slf4j.Slf4j;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import javax.annotation.Resource;

@Slf4j

@RestController

@RequestMapping("/consumer")

@DefaultProperties(defaultFallback = "paymentGlobalFallBackMethod")

public class OderHystrixController {

@Resource

private PaymentHystrixService paymentHystrixService;

@GetMapping("/payment/hystrix/ok/{id}")

public String paymentInfo_OK(@PathVariable("id") Integer id) {

return paymentHystrixService.paymentInfo_OK(id);

}

@GetMapping("/payment/hystrix/timeout/{id}")

//@HystrixCommand(fallbackMethod = "paymentTimeOutFallbackMethod",commandProperties = {

// @HystrixProperty(name = "execution.isolation.thread.timeoutInMilliseconds",value = "1500")

//})

@HystrixCommand //用全局的fallback方法

public String paymentInfo_TimeOut(@PathVariable("id") Integer id) {

return paymentHystrixService.paymentInfo_TimeOut(id);

}

public String paymentTimeOutFallbackMethod(@PathVariable("id") Integer id) {

return "我是消费者80,对方支付系统繁忙请10秒钟后再试或者自己运行出错请检查自己,o(╥﹏╥)o";

}

/**

*下面是全局fallback方法

*/

public String paymentGlobalFallBackMethod(){

return "Global异常处理信息,请稍后再试,/(ㄒoㄒ)/~~";

}

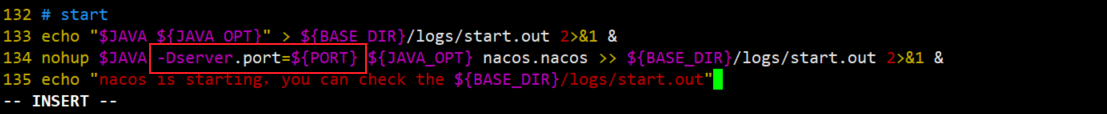

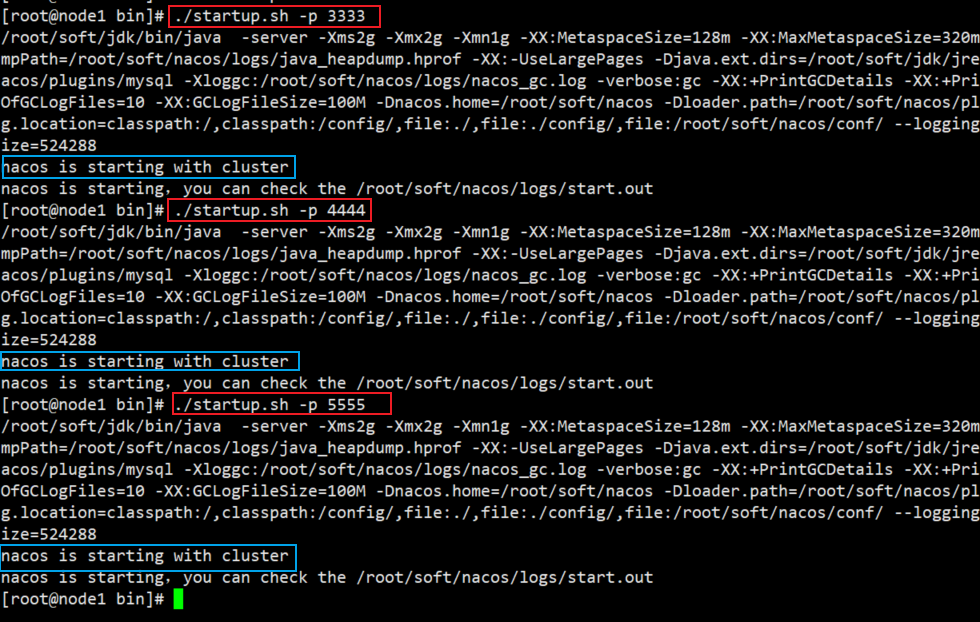

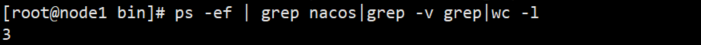

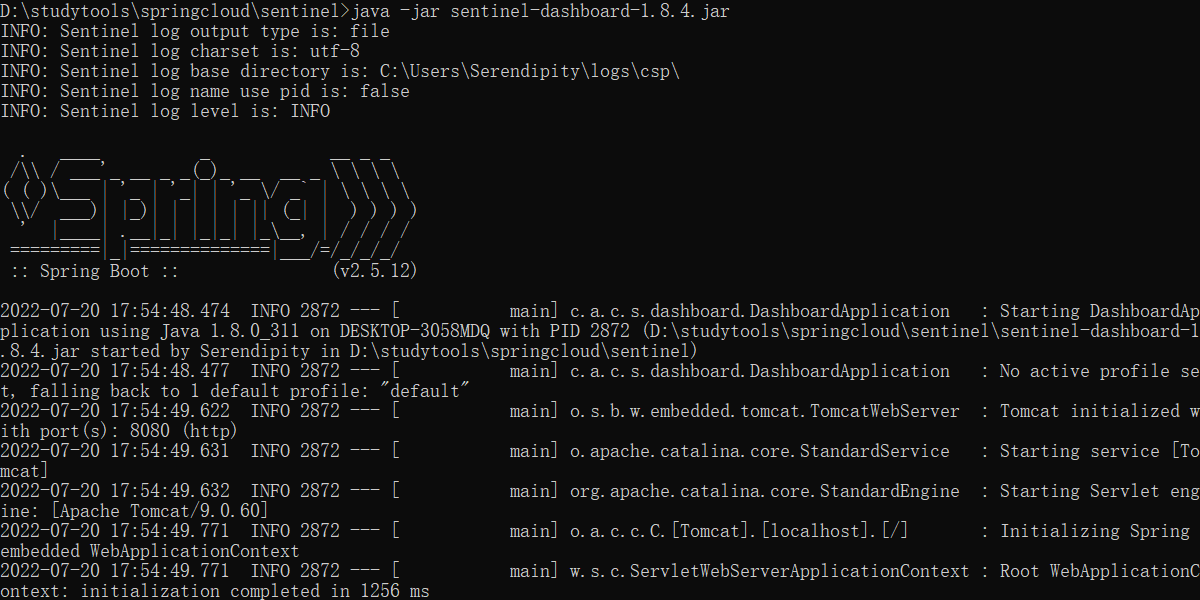

}通配服务降级FeignFallback

目前问题2 统一和自定义的分开,代码混乱

服务降级,客户端去调用服务端,碰上服务端宕机或关闭

本次案例服务降级处理是在客户端80实现完成的,与服务端8001没有关系,只需要为Feign客户端定义的接口添加一个服务降级处理的实现类即可实现解耦

未来我们要面对的异常

运行

超时

- 宕机

修改cloud-consumer-feign-hystrix-order80

根据cloud-consumer-feign-hystrix-order80已经有的PaymentHystrixService接口,

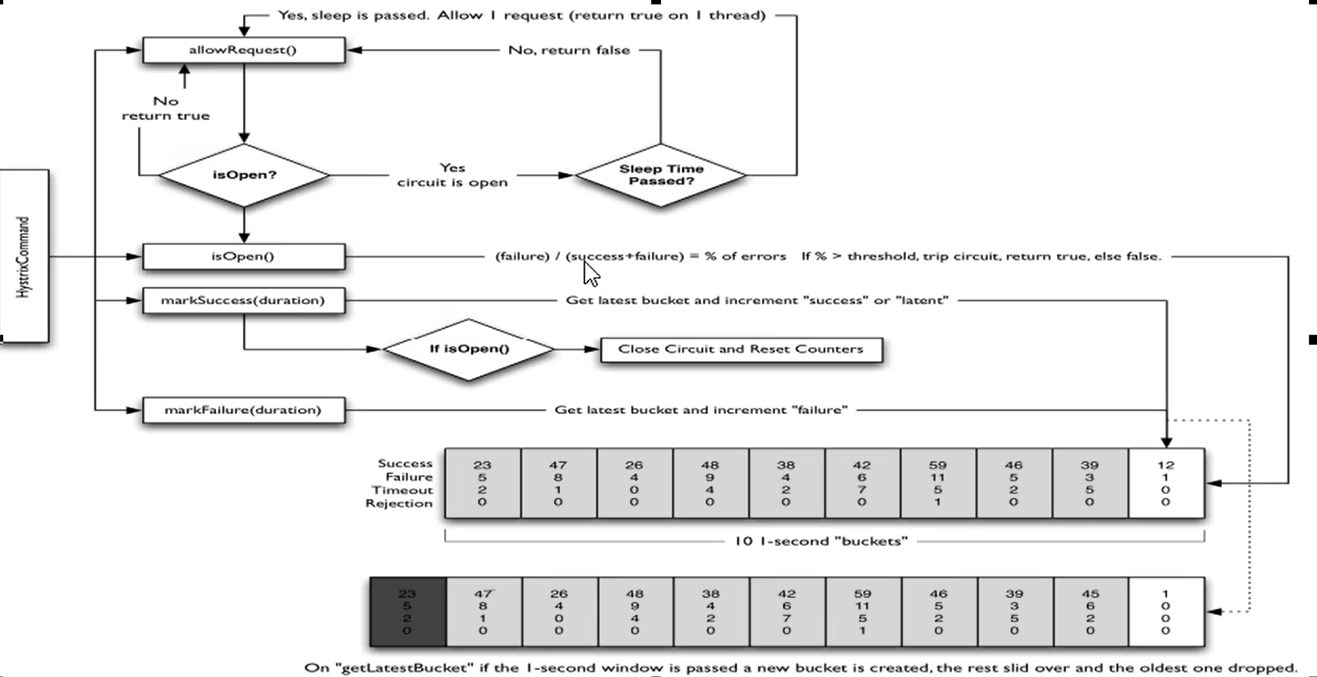

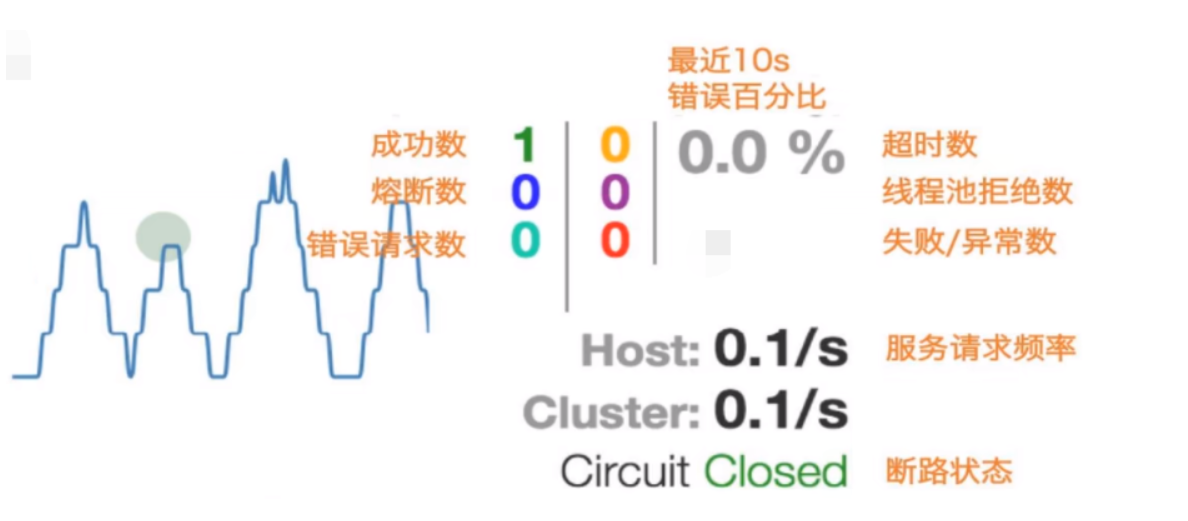

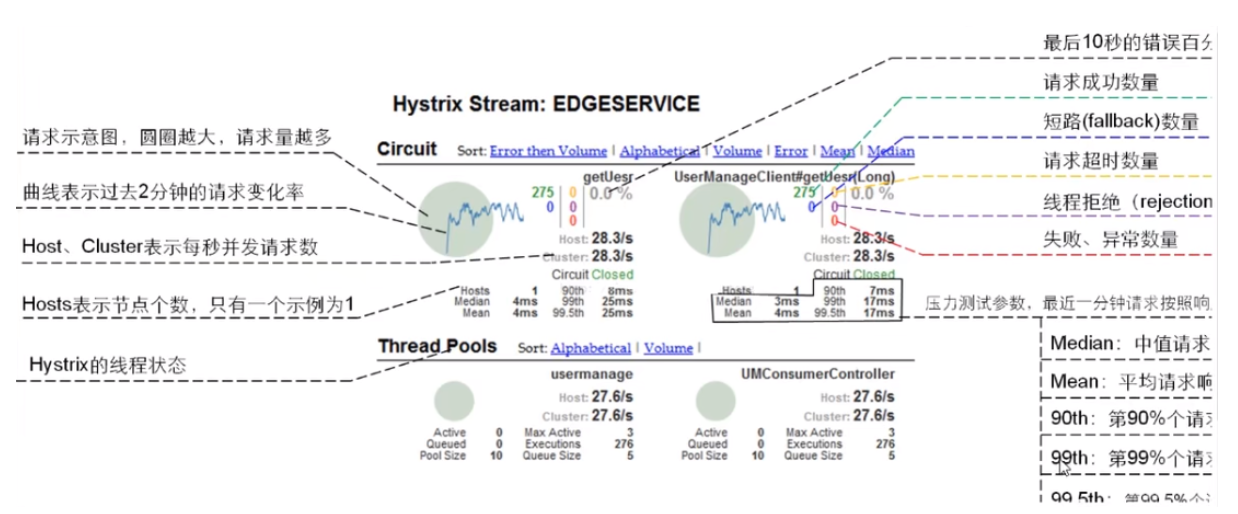

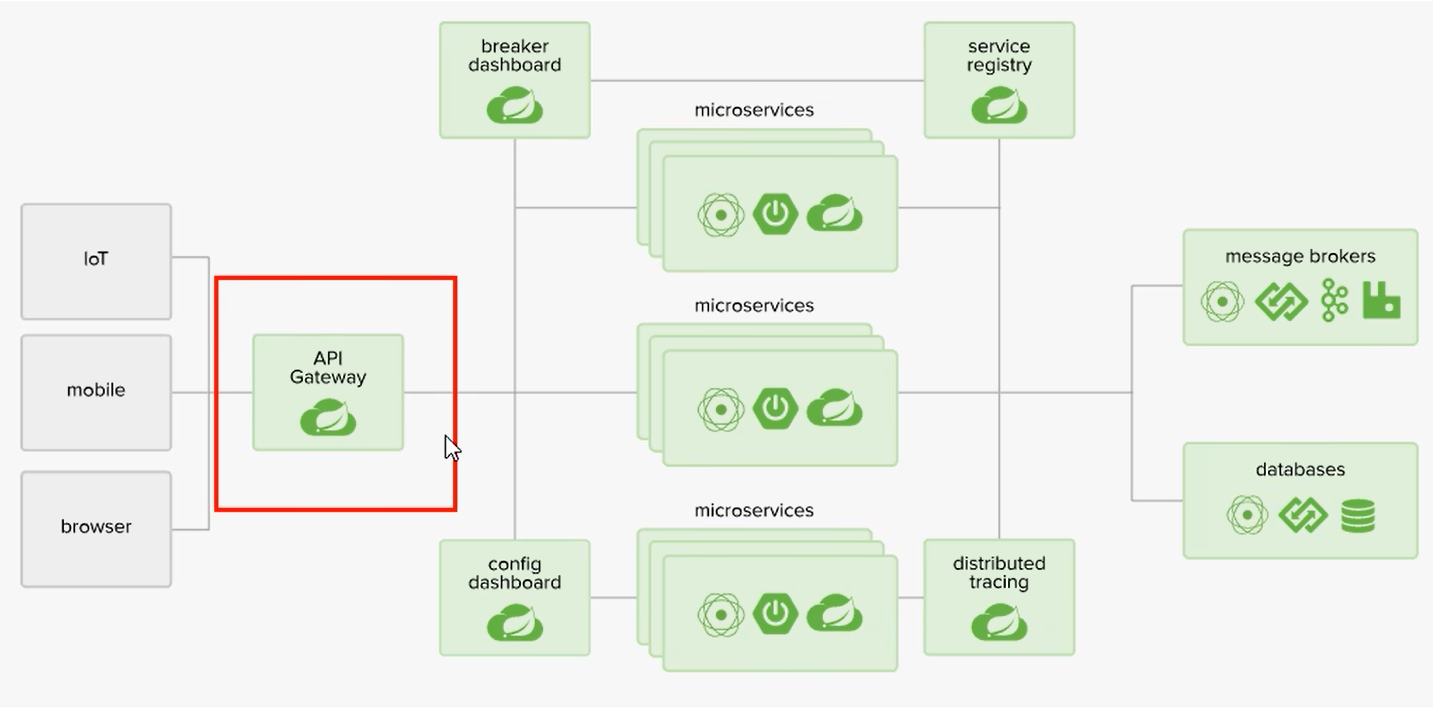

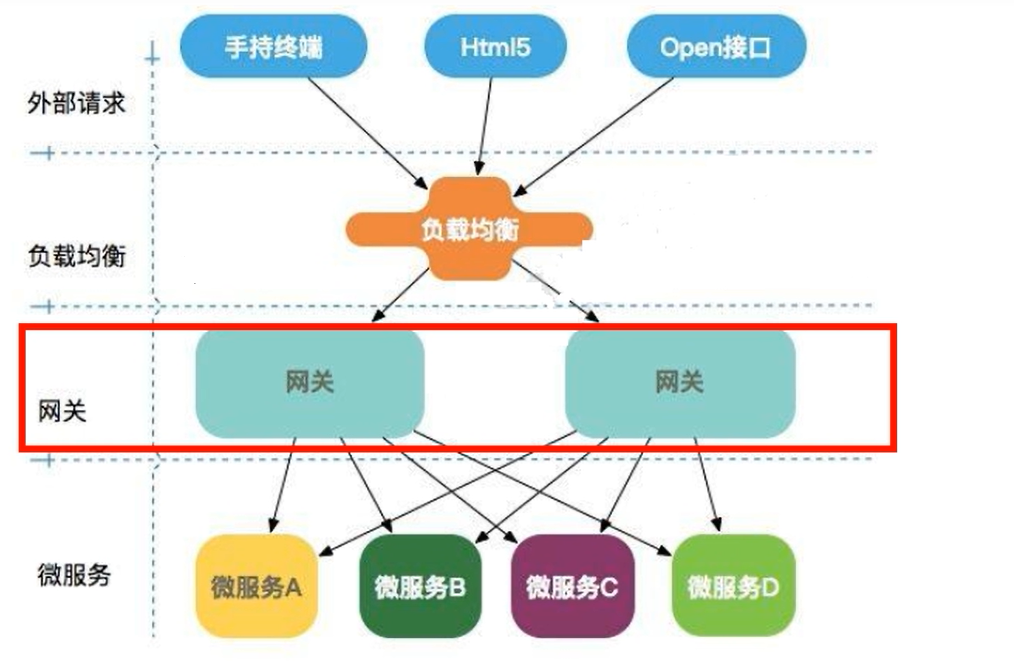

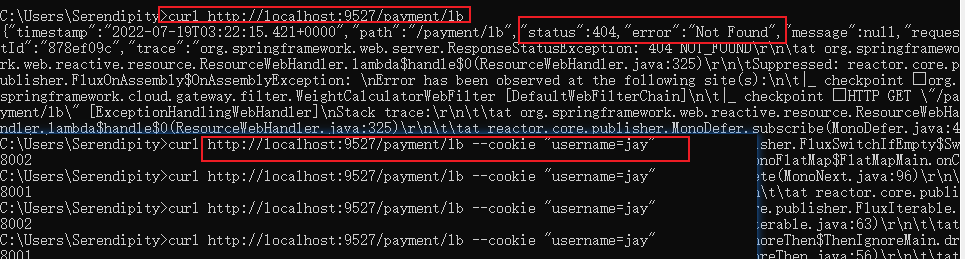

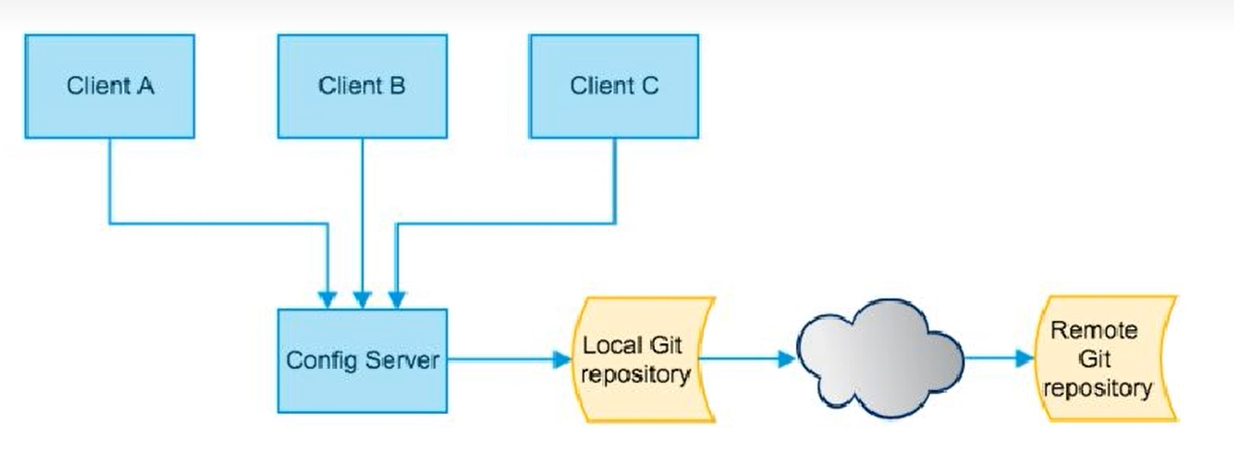

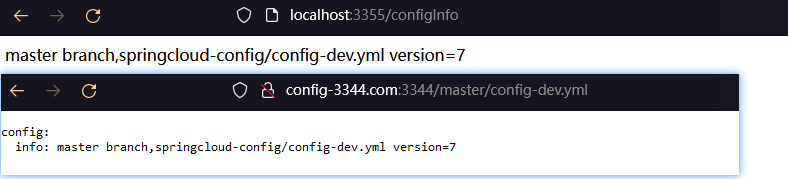

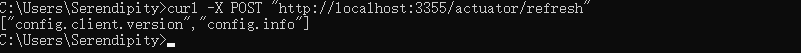

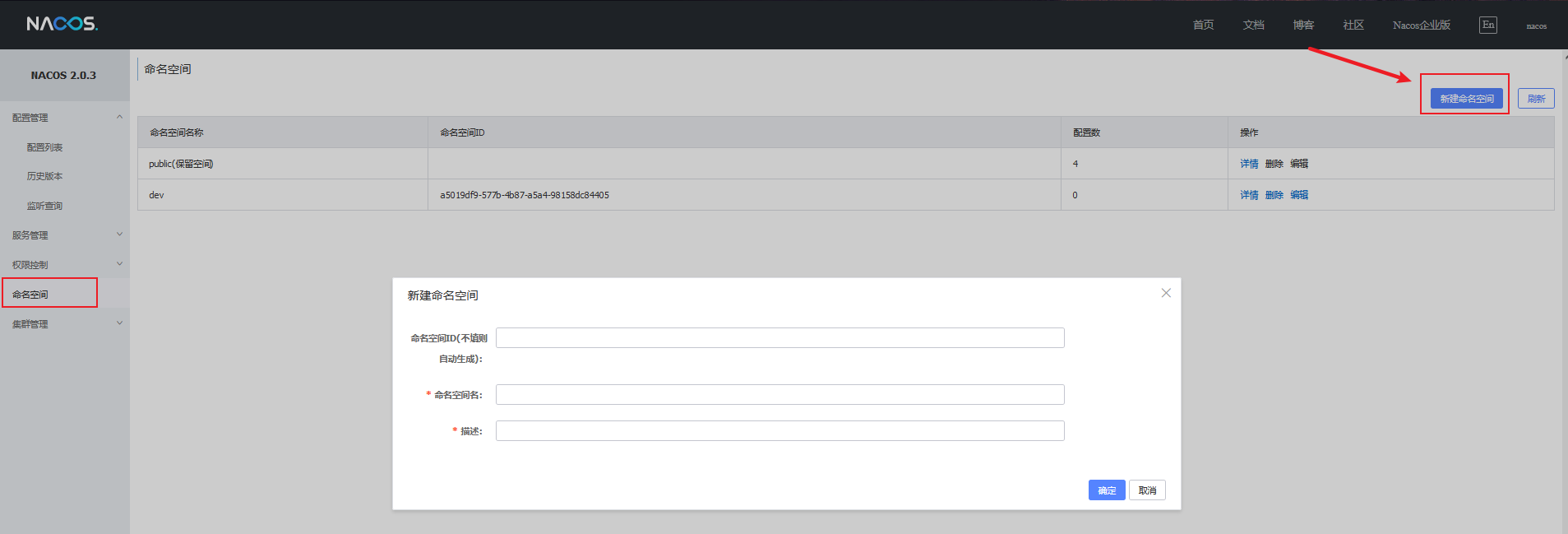

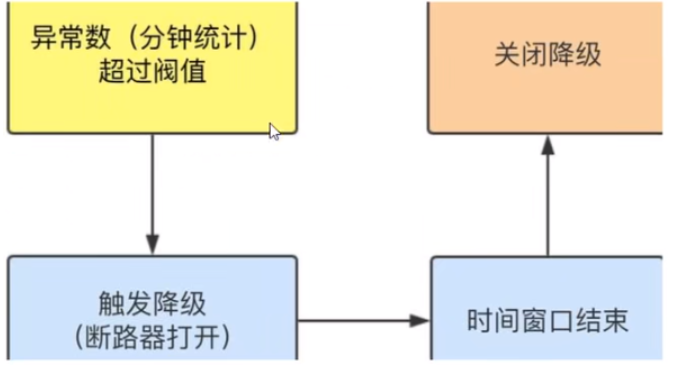

重新新建一个类(PaymentFallbackService)实现该接口,统一为接口里面的方法进行异常处理